Harcèlement & IA - Page 2

Lois d'échelle en pratique : Quand arrêter l'entraînement des grands modèles de langage

- King Willie

- |

- |

- 9

Les lois d'échelle permettent de prédire comment les modèles de langage s'améliorent avec la taille. Mais en pratique, les entreprises sur-entraînent souvent leurs modèles pour améliorer la performance en inférence. Voici quand arrêter, selon les données réelles de 2026.

Voir plusPourquoi l'IA générative hallucine : les limites des modèles linguistiques probabilistes

- King Willie

- |

- |

- 8

Les IA génératives inventent des faits avec une crédibilité troublante. Ce n’est pas un bug, c’est une limite fondamentale de leur architecture. Voici pourquoi elles hallucinent - et pourquoi aucune solution actuelle ne les élimine complètement.

Voir plusQuand passer d’un MVP vibe-coded à une ingénierie de production

- King Willie

- |

- |

- 8

Le vibe-coding permet de lancer un MVP rapidement, mais il s'effondre en production. Découvrez les signaux clés pour passer à une ingénierie sérieuse avant que votre produit ne devienne une dette technique insurmontable.

Voir plusCollecte et nettoyage de données pour l'entraînement des LLM : Guide pratique 2026

- King Willie

- |

- |

- 9

La collecte et le nettoyage de données pour l'entraînement des modèles linguistiques déterminent leurs performances. En 2026, des méthodes comme BETR et Dolma optimisent la qualité des données, avec un taux de rejet de 75%. Découvrez les étapes clés, défis et tendances pour des LLM performants.

Voir plusPourquoi les LLM excèlent dans de nombreuses tâches : transfert, généralisation et capacités émergentes

- King Willie

- |

- |

- 10

Les modèles de langage de grande taille (LLM) surpassent de nombreuses tâches grâce à l'apprentissage par transfert, la généralisation et les capacités émergentes. Ces mécanismes permettent d'adapter rapidement les modèles à de nouveaux domaines avec peu de données, tout en développant des compétences imprévues à grande échelle.

Voir plusChoisir les familles de modèles pour des programmes LLM évolutifs : guide pratique

- King Willie

- |

- |

- 9

Guide pratique pour choisir la bonne famille de modèles LLM en 2026 entre GPT-4o, Claude 3, Gemini, Llama 4 et Qwen. Apprenez à équilibrer performance, coût et compétences techniques selon votre cas d'usage.

Voir plusPrototypage accessible dès le départ avec le vibe coding : des tactiques qui fonctionnent vraiment

- King Willie

- |

- |

- 0

Découvrez comment le vibe coding avec une approche accessibilité dès le départ permet de créer des prototypes conformes aux normes WCAG en seulement 72 heures, en intégrant les exigences d'accessibilité dans les premiers prompts IA.

Voir plusProtéger les poids des modèles et la propriété intellectuelle dans les grands modèles linguistiques

- King Willie

- |

- |

- 10

Protéger les poids des grands modèles linguistiques est essentiel pour prévenir le vol d'IA. Découvrez comment le fingerprinting, les empreintes dans les poids et les watermarkings rendent les modèles inviolables et juridiquement protégés.

Voir plusIA générative en santé : découverte de médicaments, imagerie médicale et soutien clinique

- King Willie

- |

- |

- 0

L'IA générative transforme la santé : elle accélère la découverte de médicaments, améliore les diagnostics par imagerie et soutient les médecins dans leurs décisions. Découvrez comment elle fonctionne, ses limites et son avenir.

Voir plusProgrammation Local-First : Exécuter les modèles et outils directement sur votre machine

- King Willie

- |

- |

- 9

La programmation local-first permet d'exécuter des modèles d'IA et des outils de développement directement sur votre machine, sans dépendre du cloud. Idéal pour la souveraineté des données, mais avec une courbe d'apprentissage raide.

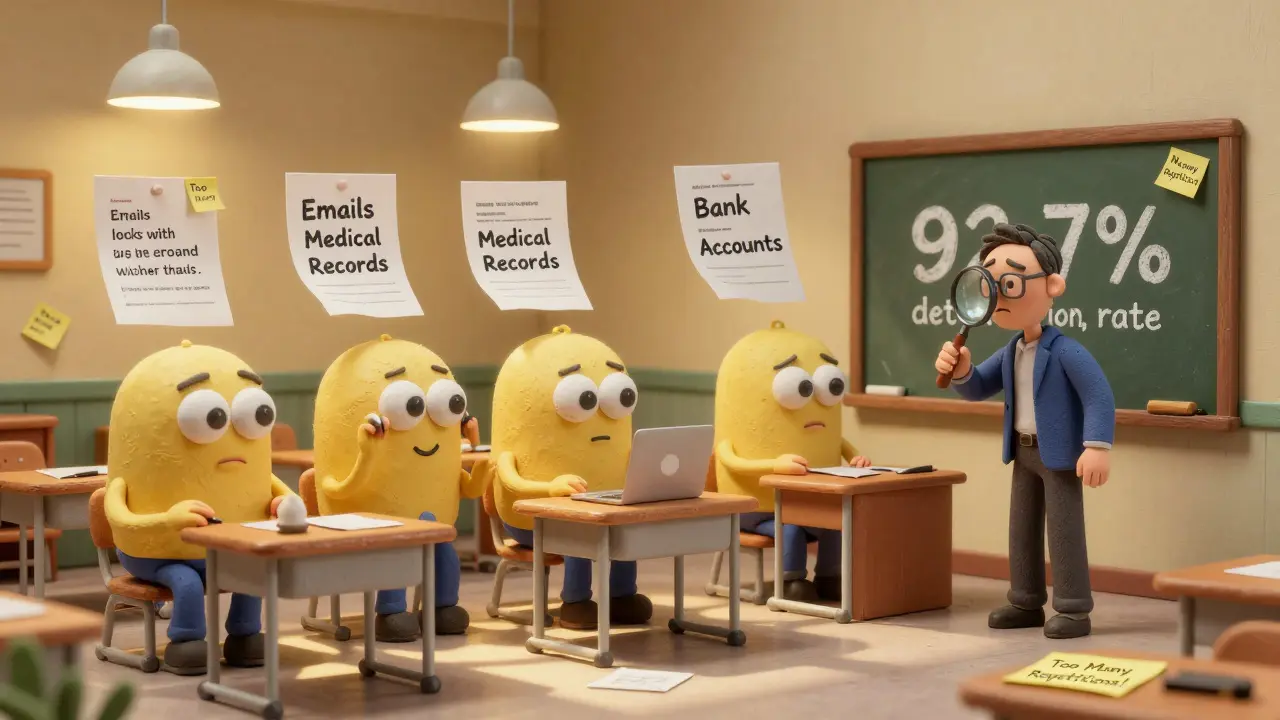

Voir plusRisques de mémorisation dans les LLM : détecter et atténuer les fuites de données d'entraînement

- King Willie

- |

- |

- 9

La mémorisation dans les modèles linguistiques peut révéler des données privées. Découvrez comment la détecter, pourquoi elle est dangereuse, et les meilleures méthodes pour l'atténuer en 2026.

Voir plusMise en cache et performance dans les applications web générées par l'IA : par où commencer

- King Willie

- |

- |

- 6

La mise en cache est essentielle pour réduire les coûts et la latence des applications web générées par l'IA. Découvrez comment commencer avec Redis ou MemoryDB, les différences entre les types de cache, et les erreurs à éviter.

Voir plus