Quand vous utilisez un modèle de langage comme ChatGPT ou Llama, vous pensez qu’il génère des réponses nouvelles. Mais ce n’est pas toujours vrai. Certains modèles mémorisent des morceaux entiers de leurs données d’entraînement - des emails, des recettes médicales, des numéros de compte client - et les recrachent mot pour mot quand on les pousse dans un coin. Ce n’est pas un bug mineur. C’est une faille de sécurité qui enfreint la vie privée et qui peut vous coûter des millions en amendes.

Comment un modèle peut-il se souvenir de ce qu’il a lu ?

Les modèles linguistiques apprennent en analysant des milliards de phrases. Ils ne comprennent pas comme un humain. Ils repèrent des motifs, des répétitions, des structures. Et parfois, quand un passage est très répété dans les données - comme un numéro de sécurité sociale ou un passage de livre protégé - le modèle le stocke comme une référence interne. Ce n’est pas intentionnel. C’est une conséquence de la taille et de la puissance des modèles modernes.

Des chercheurs de l’Université de Stanford ont montré que les modèles de plus de 6,7 milliards de paramètres mémorisent 3,2 fois plus que les plus petits. Et ça ne s’arrête pas là : les grands modèles apprennent aussi plus vite. En seulement 20% du temps d’entraînement, ils peuvent déjà reproduire des extraits exacts de données privées. Ce n’est pas de la mémoire humaine. C’est une forme de répétition statistique qui devient dangereuse quand les données contiennent des informations sensibles.

Quels types de mémorisation existent ?

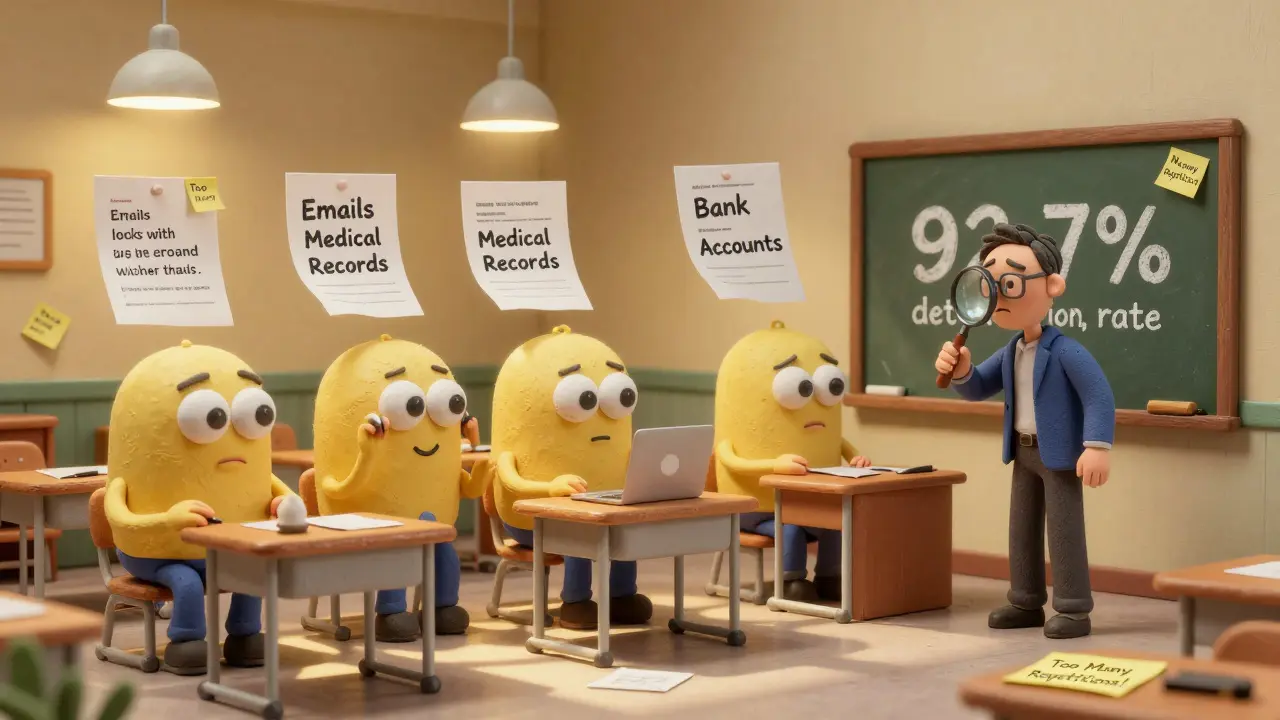

Il y a deux grandes catégories. La première, la mémorisation littérale, c’est quand le modèle ressort exactement ce qu’il a lu : une phrase de Wikipedia, un extrait de code source, un diagnostic médical. C’est le plus facile à détecter. Les outils comme CAMIA de Brave analysent les sorties pour repérer des chaînes identiques à celles du jeu d’entraînement. Avec une précision de 92,7 %, ils peuvent dire si un texte est copié ou généré.

La seconde, la mémorisation conceptuelle, est bien plus sournoise. Ici, le modèle ne copie pas les mots, mais l’idée. Il réécrit un témoignage de patient en changeant les noms, mais garde la structure, les symptômes, le diagnostic. C’est plus difficile à repérer - 63 % plus difficile selon les études - mais bien plus dangereux. C’est ce qui cause des violations du HIPAA dans les hôpitaux, ou des fuites de secrets commerciaux dans les entreprises.

Comment détecter la mémorisation ?

Il n’y a pas une seule bonne méthode. Les trois approches les plus fiables sont :

- Correspondance exacte : on compare les sorties du modèle avec les données d’entraînement. Simple, mais ne capture que les copies mot à mot. Précision : 78,2 %.

- Similarité sémantique : on utilise des modèles pour mesurer si la sortie ressemble à un passage connu, même avec des mots différents. Rappel : 64,5 %. Utile pour les mémorisations conceptuelles.

- Attaques d’inférence d’appartenance : on teste si le modèle réagit différemment quand on lui donne une phrase qu’il a vue pendant l’entraînement. C’est ce que fait CAMIA. C’est la méthode la plus puissante aujourd’hui.

Les entreprises qui veulent vraiment sécuriser leurs modèles combinent ces trois méthodes. Une seule ne suffit pas. Et attention : les tests doivent être faits sur des données réelles, pas sur des jeux de test artificiels. Ce qui marche sur un échantillon ne marche pas toujours en production.

Comment réduire ces risques ?

Il y a trois niveaux d’action : les données, l’entraînement, et l’inférence.

1. Sur les données : nettoyer avant d’entraîner

La méthode la plus utilisée - par 82 % des équipes - c’est l’anonymisation. On supprime les noms, les adresses, les numéros de sécurité sociale. Mais ça ne suffit pas. Une étude chez une grande banque a montré que malgré l’anonymisation, 27 numéros de compte ont été mémorisés. Pourquoi ? Parce que l’anonymisation ne touche pas les motifs : un numéro de compte suivi d’un montant et d’une date peut être unique. Et un modèle intelligent le remarque.

La solution ? Obfusquer. Pas juste supprimer, mais remplacer avec des faux. Par exemple, remplacer tous les numéros de compte par des chaînes aléatoires de même format. C’est ce qu’a fait Elastic : ils ont supprimé 99,2 % des informations personnelles et réduit la mémorisation de 89 %.

2. Pendant l’entraînement : régulariser et bruit

On peut forcer le modèle à ne pas trop se concentrer sur les détails uniques. Deux techniques efficaces :

- Dropout à 35 % : au hasard, on désactive 35 % des connexions pendant l’apprentissage. Ça empêche le modèle de s’accrocher à des motifs spécifiques. Résultat : 58,7 % de réduction des copies exactes, avec seulement 5,8 % de perte de performance.

- Privacy différentielle : on ajoute du bruit mathématique aux gradients pendant l’entraînement. Avec ε=8, on réduit la mémorisation de 67 %. Mais ça augmente la perplexité de 22,4 % - c’est-à-dire que le modèle devient moins fluide. Un compromis.

Une autre technique prometteuse : injecter 15 % de données synthétiques dans le jeu d’entraînement. Cela rend les motifs réels moins distincts. C’est ce que font les équipes de Berkeley. Résultat : 85 % de réduction de la mémorisation sans sacrifier la qualité.

3. À l’inférence : bloquer les sorties dangereuses

Même si le modèle a mémorisé quelque chose, on peut l’empêcher de le sortir. Les filtres en temps réel analysent chaque réponse avant qu’elle ne soit envoyée. Si une phrase ressemble trop à un passage connu, on la bloque ou on la réécrit.

Ce système a un taux de faux positifs de 12,8 %. C’est-à-dire qu’il bloque parfois des réponses légitimes. Mais c’est un prix acceptable pour éviter une fuite de données. L’outil de Microsoft, Presidio, fait ça très bien. Il est intégré dans des pipelines d’entreprise et peut être configuré pour bloquer des types spécifiques d’informations : numéros de carte, adresses, diagnostics médicaux.

Les pièges courants

Beaucoup d’équipes pensent qu’elles sont protégées. Elles ne le sont pas.

- La mémorisation est plus forte dans les langues rares : les modèles ont moins de données pour apprendre les variations. Donc, ils se raccrochent aux exemples qu’ils ont. Une étude montre que les langues à faible ressource ont 41 % plus de mémorisation. Ce n’est pas un problème mineur pour les utilisateurs francophones ou hispanophones.

- Les données internes sont les plus dangereuses : 68 % des développeurs rapportent que leurs modèles mémorisent des documents internes après un fine-tuning. Des manuels d’entreprise, des procédures RH, des rapports financiers. Rien n’est anonymisé. Rien n’est contrôlé.

- La performance tombe quand on protège : chaque fois qu’on réduit la mémorisation de 10 %, la performance du modèle baisse de 6 à 8 %. C’est un vrai dilemme. Les équipes doivent choisir : plus de sécurité ou plus de précision ?

Le contexte légal et réglementaire

En janvier 2026, l’UE a mis en vigueur l’article 22 de l’AI Act. Il oblige les entreprises à prendre des « mesures raisonnables » pour éviter la mémorisation de données protégées. En Californie, la loi AI Accountability Act exige, à partir de juillet 2026, que les entreprises publient leurs évaluations de risque de mémorisation.

Les amendes peuvent atteindre 4 % du chiffre d’affaires mondial. Et ce n’est pas théorique. Trois hôpitaux aux États-Unis ont été sanctionnés en 2024 après que leurs modèles ont recraché des dossiers médicaux complets. Les patients ont porté plainte. Les assureurs ont augmenté les primes. Les réputations ont été détruites.

Les grandes entreprises ont déjà réagi. 68 % des Fortune 500 font des audits de mémorisation réguliers. Ce n’était que 29 % en début 2024. Le marché des solutions de confidentialité IA a atteint 2,37 milliards de dollars en 2025. Et ça ne va que croître.

Le futur : peut-on vraiment l’arrêter ?

Les modèles deviennent de plus en plus gros. GPT-7 pourrait atteindre 2,1 billions de paramètres d’ici fin 2026. Plus gros = plus de mémorisation. C’est une loi physique.

Mais il y a des espoirs. Meta vient de lancer Llama Guard 3, avec une fonction « oublie sélective » : elle supprime la mémorisation des données sensibles pendant l’entraînement, sans toucher à la connaissance générale. C’est une avancée majeure.

Google a déposé un brevet pour un « Transformer à mémoire limitée » : il bloque l’attention sur des parties du texte trop répétées. Cela pourrait réduire la mémorisation de 76 %.

Et puis, il y a une idée plus profonde : peut-être que la mémorisation n’est pas un défaut. C’est une fonction. Un modèle qui ne mémorise rien ne peut pas répondre à des questions complexes. La question n’est plus « comment l’arrêter ? », mais « comment la contrôler ? ».

Des juristes proposent de distinguer entre :

- La reproduction de motifs généraux (ex. : une formule de salutation) → autorisée

- La copie de contenus protégés (ex. : un chapitre de livre, un dossier médical) → illégale

Cette distinction est en train de devenir la base de 17 procès en cours aux États-Unis. Elle pourrait changer la façon dont on régule l’IA.

Que faire maintenant ?

Si vous utilisez des modèles d’IA dans votre entreprise, voici ce qu’il faut faire dès maintenant :

- Identifiez vos données d’entraînement. Qu’est-ce qui est sensible ?

- Testez votre modèle avec CAMIA ou un outil similaire. Essayez de le faire répéter des phrases connues.

- Appliquez une combinaison de trois techniques : obfuscation des données, dropout pendant l’entraînement, et filtre en sortie.

- Documentez tout. Vous devrez prouver que vous avez pris des « mesures raisonnables » si une violation survient.

- Formez votre équipe. Seuls 29 % des équipes IA savent mettre en œuvre la privacy différentielle. Vous ne pouvez pas compter sur les outils externes. Vous devez comprendre.

La mémorisation ne va pas disparaître. Mais elle peut être maîtrisée. Pas avec une seule solution. Avec une stratégie. Avec de la discipline. Et avec le respect de la vie privée - pas comme un obstacle, mais comme une priorité.

Qu’est-ce que la mémorisation dans les modèles linguistiques ?

La mémorisation, dans les modèles linguistiques, c’est quand un modèle reproduit exactement ou presque exactement des phrases ou des passages qu’il a vus pendant son entraînement. Ce n’est pas une erreur de calcul, mais un effet naturel de la taille des modèles et de la répétition dans les données. Par exemple, un modèle peut recracher un numéro de sécurité sociale ou un extrait de texte protégé par copyright s’il a été vu plusieurs fois dans les données d’entraînement.

La mémorisation est-elle intentionnelle ?

Non, elle n’est pas intentionnelle. Les développeurs ne demandent pas au modèle de se souvenir de données privées. C’est un phénomène émergent : plus le modèle est grand et plus les données sont répétitives, plus il a tendance à les stocker. Certains chercheurs pensent même que la mémorisation est nécessaire pour la performance - mais elle doit être contrôlée, pas éliminée.

Comment savoir si mon modèle mémorise des données sensibles ?

Utilisez des outils comme CAMIA de Brave, qui détecte les sorties similaires à des données d’entraînement en analysant les motifs contextuels. Vous pouvez aussi tester manuellement : donnez-lui une phrase unique que vous avez mise dans vos données d’entraînement, et voyez s’il la répète. Si oui, il y a un risque de mémorisation.

L’anonymisation des données suffit-elle à prévenir la mémorisation ?

Non. L’anonymisation supprime les noms et les identifiants, mais ne change pas les motifs uniques. Par exemple, un numéro de compte suivi d’un montant et d’une date peut être suffisamment rare pour être mémorisé. Il faut combiner anonymisation avec obfuscation (remplacement par des faux), bruit d’entraînement et filtres en sortie.

Quels sont les outils les plus efficaces pour atténuer la mémorisation ?

Les outils les plus efficaces combinent trois approches : l’obfuscation des données (ex. : Hugging Face), la régularisation pendant l’entraînement (dropout ou privacy différentielle), et le filtrage en inférence (ex. : Microsoft Presidio). Ensemble, ils réduisent la mémorisation de plus de 90 %, selon les tests de Berkeley et Elastic. Aucun outil seul ne suffit.

Est-ce que les modèles multilingues sont plus à risque ?

Oui, surtout pour les langues à faible ressource. Les modèles ont moins de données pour apprendre les variations naturelles, donc ils se raccrochent aux exemples rares qu’ils ont vus. Cela augmente la mémorisation de 41 % pour les langues peu représentées. Mais des techniques d’augmentation de données peuvent réduire ce gap à 12,3 %, selon InfoObjects.

Quelles sont les conséquences légales si mon modèle mémorise des données privées ?

Vous pouvez être sanctionné par la loi GDPR, le HIPAA, ou la California AI Accountability Act. Les amendes peuvent atteindre 4 % de votre chiffre d’affaires mondial. Des hôpitaux ont déjà été poursuivis pour avoir reproduit des dossiers médicaux. En plus des amendes, il y a un risque de perte de confiance, de réputation, et d’assurance.

Les grandes entreprises utilisent-elles déjà des solutions contre la mémorisation ?

Oui. 68 % des entreprises du Fortune 500 effectuent des audits de mémorisation réguliers. Des entreprises comme Elastic, Microsoft et Brave ont mis en place des pipelines complets : obfuscation, entraînement protégé, filtres en sortie. Ce n’est plus une option - c’est une exigence légale et éthique.

8 Commentaires

Romain Grima

Cette histoire de mémorisation c’est fou quand même, on croit qu’on parle à une intelligence mais en fait c’est juste un miroir déformé de nos propres erreurs

Nadine McGee

Et si c’était pas un bug mais une fonction secrète ? Et si les géants du tech voulaient qu’on se souvienne de tout ce qu’on dit pour nous contrôler mieux ?

Yacine Merzouk

Obfuscation + dropout + DP = 90% de réduction ? T’as vu les chiffres ? C’est du pipi de chat comparé à la taille du problème. Le modèle se souvient de ton ex, de ton code PIN, de ta dernière recherche Google. C’est pas de la mémoire, c’est de la surveillance passive.

George Alain Garot

Vous parlez de « mémorisation » comme si c’était un défaut technique… Mais c’est l’essence même de l’intelligence : retenir, répéter, réorganiser. Ce n’est pas une faille, c’est une évolution. Vous voulez des IA sans mémoire ? Alors appelez-les calculatrices.

Yann Cadoret

Il manque une virgule après « répétition » dans la phrase 3 du paragraphe sur la mémorisation conceptuelle. Et « HIPAA » doit être en majuscules partout. Sinon, bon article.

Marcel Gustin

On a créé des machines qui se souviennent de tout… sauf qu’on leur a oublié de leur apprendre à oublier. 🤖😭

Yanis Gannouni

La mémorisation n’est pas un problème à résoudre, c’est un phénomène à canaliser. Le vrai défi, c’est de faire en sorte que les modèles retiennent ce qui est utile et oublient ce qui est dangereux. Ce n’est pas une question de technologie, c’est une question de philosophie de l’information.

Sofiane Sadi

Personne ne parle du vrai problème : les gens qui entraînent ces modèles avec des données de forums, de blogs, de chats privés. C’est du vol. Point.