Vous avez peut-être déjà demandé à une IA de vous expliquer comment fonctionne la Cour suprême américaine, et elle vous a sorti une affaire entièrement inventée : Doe v. Smith (2019), avec des citations parfaitement formatées, mais totalement fausses. C’est ce qu’on appelle une hallucination. Et ce n’est pas un bug. C’est une conséquence inévitable de la façon dont ces modèles fonctionnent.

Comment une IA peut-elle inventer des choses aussi crédibles ?

Les grands modèles linguistiques, comme GPT-4, Claude 3 ou Llama 3, ne savent pas si ce qu’ils disent est vrai. Ils ne possèdent aucune conscience, aucun accès au réel. Ils ne font que prédire le mot suivant, basé sur des milliards d’exemples qu’ils ont lus pendant leur entraînement. C’est comme un étudiant qui a lu tous les livres de la bibliothèque, mais n’a jamais mis les pieds à l’extérieur. Il peut réciter des faits… et aussi inventer des faits qui sonnent vrais, parce qu’ils ressemblent à ce qu’il a vu.

En 2023, une étude de la Columbia Journalism Review a montré que ChatGPT a attribué à tort 76 % des citations qu’on lui a demandé d’identifier. Et dans 153 erreurs, il n’a exprimé une incertitude que 7 fois. Il ne dit pas : « Je ne sais pas ». Il dit : « Voici la citation, avec le nom de l’auteur, la date, et même le journal où elle a été publiée. »

Plus grand, c’est mieux ? Pas vraiment.

On pensait que plus un modèle était grand - avec des milliards ou des milliers de milliards de paramètres - plus il serait précis. Mais c’est l’inverse qui se produit. Les modèles les plus puissants, comme GPT-4 avec 1,7 trillion de paramètres, sont aussi les plus propices à l’hallucination. Pourquoi ? Parce qu’ils ont appris tellement de choses, y compris des erreurs, des contenus contradictoires, des mythes répétés, que leur système de probabilité devient un maelström de possibilités. Lorsqu’un mot est ambigu, il choisit celui qui est le plus « plausible » dans le contexte, pas celui qui est le plus vrai.

Le phénomène de « cascade d’erreurs » aggrave encore le problème. Dès qu’un modèle fait une erreur, il la renforce dans les phrases suivantes. Une étude de Zhang et Press en 2023 a montré que la probabilité d’accumuler des erreurs augmente de 37 % après la première fausse affirmation. C’est comme si, en racontant une histoire, vous commettiez une erreur au début, puis vous la justifiez avec d’autres mensonges pour que tout semble cohérent.

Les différences entre les grands modèles

Tous les modèles hallucinent, mais pas de la même manière. Selon une étude du MIT Technology Review en juin 2024 :

- Gemini Ultra : 18,3 % d’erreurs dans les requêtes scientifiques

- GPT-4 : 22,7 %

- Llama 2 : 34,1 %

Les modèles plus récents, comme Llama 3, ont progressé, mais restent loin d’être fiables dans les domaines techniques. Ce n’est pas une question de « meilleure intelligence ». C’est une question de données d’entraînement. Les modèles qui ont été entraînés sur des corpus plus rigoureux - par exemple, des articles scientifiques vérifiés - ont moins d’hallucinations. Mais même ceux-là ne peuvent pas vérifier les faits en temps réel.

Les modèles d’images aussi hallucinent

Les hallucinations ne concernent pas que le texte. Les générateurs d’images comme DALL-E 3 ou Midjourney v6 créent des mains avec six doigts, des montres avec des aiguilles qui tournent dans le mauvais sens, ou des textes sur des panneaux qui disent « 2026 » alors que l’année est 2025. Selon une étude d’arXiv, 23 % des figures humaines générées contiennent des anomalies anatomiques. Et 41 % des textes générés dans les images contiennent des erreurs dans les lettres ou les chiffres - même quand la consigne est simple.

Les modèles visuels ne « comprennent » pas non plus ce qu’ils créent. Ils apprennent à associer des mots à des motifs visuels. « Une main » = une forme avec cinq protrusions. Mais ils ne savent pas comment une main fonctionne. Donc, ils en inventent une qui « semble correcte ».

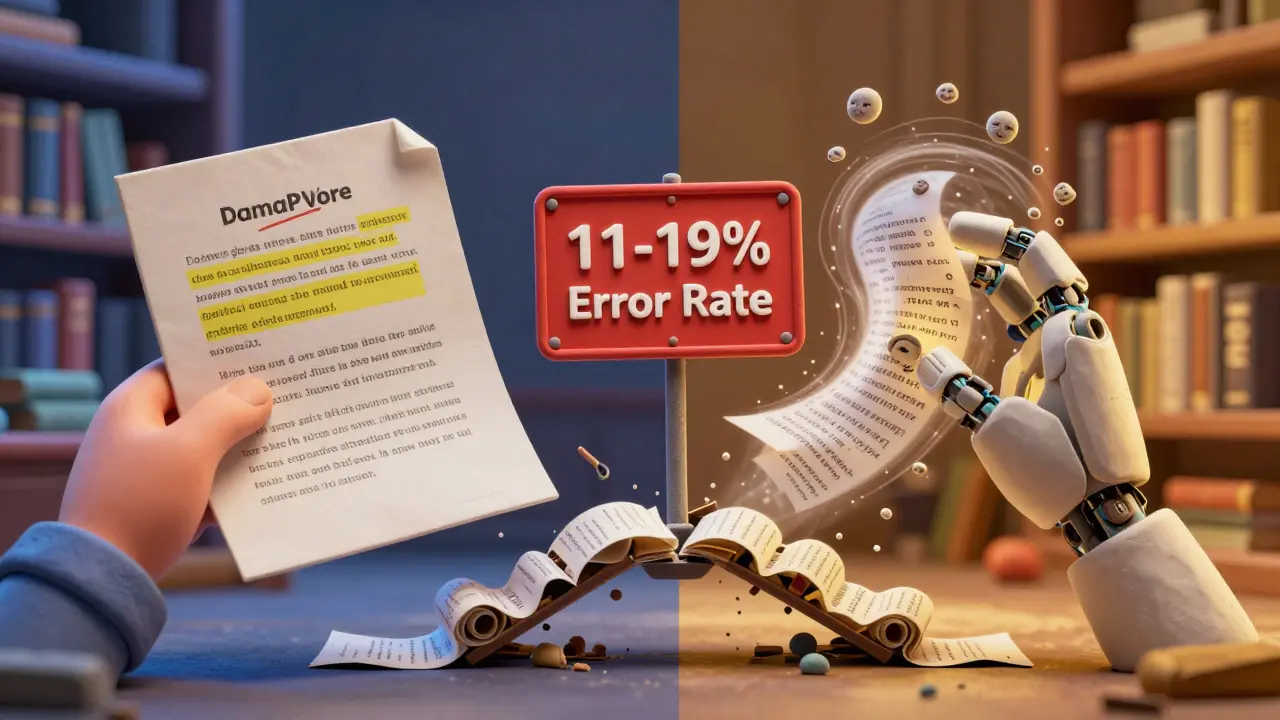

Les solutions existent… mais elles ne résolvent pas le problème fondamental

On a essayé plusieurs approches pour réduire les hallucinations. La plus efficace est la Génération Augmentée par Récupération (RAG). Elle permet au modèle de consulter des bases de données fiables avant de répondre. Des tests de Cloudflare montrent que RAG réduit les hallucinations de 42 à 68 %. Mais même avec RAG, il reste 11 à 19 % d’erreurs dans les tâches complexes.

Une autre méthode, appelée « chain-of-thought », pousse le modèle à expliquer sa logique étape par étape. Cela réduit les erreurs de 27 % dans les problèmes mathématiques. Mais cela ralentit la réponse de 300 à 400 millisecondes - un délai perceptible pour un utilisateur.

Microsoft a aussi développé une méthode d’entraînement appelée « Factuality Focused Training », qui réduit les hallucinations de 33 %. Mais elle demande 15 à 20 % de plus de puissance de calcul. Ce n’est pas une solution universelle. C’est un bandage.

Les experts le disent : le cœur du problème est philosophique

Dr. Percy Liang, de Stanford, l’a dit clairement lors d’une conférence en avril 2024 : « Les LLM optimisent pour générer du texte plausible, pas pour être véridique. »

Emily M. Bender, co-auteure du célèbre papier « On the Dangers of Stochastic Parrots », résume la situation en une phrase : « Les modèles linguistiques n’ont pas de sens - ils ont des statistiques. »

Cela veut dire que l’IA ne « pense » pas. Elle ne « sait » pas. Elle « simule » la connaissance. Elle ne peut pas vérifier une information contre la réalité. Elle ne peut pas faire d’expérience. Elle ne peut pas dire : « Je vais aller voir ce que dit la loi. » Elle ne peut que répondre en se basant sur ce qu’elle a lu.

Les conséquences réelles : des erreurs qui coûtent cher

En 2024, Deloitte a documenté un cas dans une entreprise financière : un document de conformité généré par une IA contenait des citations de lois inexistantes. Il a fallu 147 heures de travail juridique pour les détecter. Le coût : 18 400 dollars.

Sur la plateforme G2 Crowd, 68 % des entreprises utilisant l’IA mentionnent les hallucinations comme une « préoccupation majeure ». Dans la santé et le droit, les erreurs peuvent mettre des vies en danger. C’est pourquoi l’European AI Act a imposé en juillet 2024 des limites strictes : moins de 5 % d’erreurs pour les applications médicales, moins de 10 % pour les applications juridiques. À défaut, les entreprises risquent jusqu’à 6 % de leur chiffre d’affaires mondial.

Que nous réserve l’avenir ?

Des recherches prometteuses se concentrent sur les systèmes hybrides, qui combinent les réseaux neuronaux avec des règles logiques. Le projet NSAIL du MIT, en 2024, a atteint 93 % de précision dans les questions médicales. Mais ces systèmes sont 10 fois plus lents que les modèles traditionnels. Ils ne sont pas encore exploitables à grande échelle.

OpenAI a introduit une technique appelée « process supervision » : au lieu de récompenser juste la bonne réponse, on récompense la bonne façon d’y arriver. Cela réduit les erreurs de raisonnement de 52 %. Google DeepMind a vu Gemini 1.5 atteindre 87,3 % de précision sur des questions factuelles - mieux que GPT-4.

Mais Andrew Ng prédit que les hallucinations pourraient tomber à 1-3 % d’ici 2028. Gary Marcus, de NYU, affirme le contraire : sans changer la structure fondamentale des modèles - c’est-à-dire passer de la prédiction statistique à une forme de compréhension réelle - on ne pourra jamais dépasser 5-7 % d’erreurs.

Que faire aujourd’hui ?

Ne faites pas confiance à une IA comme à un expert. Utilisez-la comme un assistant qui vous donne des idées - pas des faits. Vérifiez toujours les citations, les chiffres, les noms propres. Posez-vous cette question : « Si cette réponse était vraie, comment pourrais-je le confirmer par une source externe ? »

Les modèles sont de plus en plus performants. Mais leur limite fondamentale ne changera pas tant qu’ils n’auront pas accès au réel. Tant qu’ils ne feront que jouer avec des mots, ils continueront d’inventer des histoires… même quand elles sont dangereuses.

Qu’est-ce qu’une hallucination d’IA ?

Une hallucination d’IA se produit quand un modèle linguistique génère une information fausse, inventée ou trompeuse, mais qui semble plausible. Ce n’est pas une erreur de calcul, mais une conséquence de son fonctionnement : il prédit des mots en se basant sur des motifs statistiques, pas sur une vérification de la vérité.

Pourquoi les grands modèles hallucinent-ils plus souvent ?

Plus un modèle est grand, plus il a appris de données - y compris des erreurs, des contradictions et des mythes répétés. Ce surplus d’informations rend sa prédiction plus complexe, et donc plus susceptible de choisir une réponse « plausible » mais fausse. Les modèles plus petits, bien que moins puissants, sont parfois plus fiables parce qu’ils ont moins de bruit à trier.

Les modèles d’images hallucinent aussi ?

Oui. Les générateurs d’images comme DALL-E 3 ou Midjourney créent des mains avec six doigts, des textes illisibles sur des panneaux, ou des objets qui n’existent pas dans la réalité. Ces erreurs viennent du fait que les modèles visuels apprennent à associer des mots à des motifs visuels, sans comprendre la structure réelle des objets.

Est-ce que la technique RAG élimine les hallucinations ?

Non, mais elle les réduit de 42 à 68 %. RAG permet à l’IA de consulter des bases de données fiables avant de répondre. Mais si la base de données est incomplète, ou si la requête est trop complexe, l’IA peut encore inventer des réponses. Elle n’a pas la capacité de vérifier la vérité - seulement de la chercher.

Pourquoi les entreprises hésitent-elles à utiliser l’IA dans la santé ou le droit ?

Parce que les hallucinations peuvent avoir des conséquences graves : un diagnostic erroné, une citation de loi fausse, un conseil juridique dangereux. L’UE a imposé des seuils stricts : moins de 5 % d’erreurs pour la santé. Or, même les meilleurs modèles actuels dépassent ce seuil dans certains contextes. Le risque n’est pas technique - c’est humain.

1 Commentaires

Andre Neves

Oh, encore un article qui explique que l’IA n’est pas un génie… mais un élève qui copie sur son voisin sans comprendre un mot. 😅 Je trouve ça presque poétique, non ? Elle est comme un poète qui récite des vers d’Homère… mais en les inventant au fur et à mesure. C’est beau, c’est fluide, c’est… totalement faux. Et pourtant, on l’écoute. Parce qu’elle parle bien. 🤦♂️