Vous avez déjà essayé d’utiliser un modèle d’intelligence artificielle pour traiter des données spécifiques à votre entreprise - des contrats juridiques, des dossiers médicaux, ou des réponses en plusieurs langues - mais il a produit des réponses génériques, voire fausses ? C’est parce que les modèles fermés comme GPT-4 ne sont pas conçus pour être adaptés. Ils fonctionnent comme des boîtes noires. Vous envoyez une requête, vous recevez une réponse… et vous ne savez jamais vraiment pourquoi. Les modèles linguistiques open-source, eux, changent tout. Ils vous donnent le contrôle total : vous choisissez les données, vous ajustez le modèle, vous le faites tourner sur votre propre serveur. Et ce n’est pas juste une option technique. C’est une révolution pour les entreprises qui veulent de la précision, de la confidentialité et de la durabilité.

Open-source vs. API : La différence qui change tout

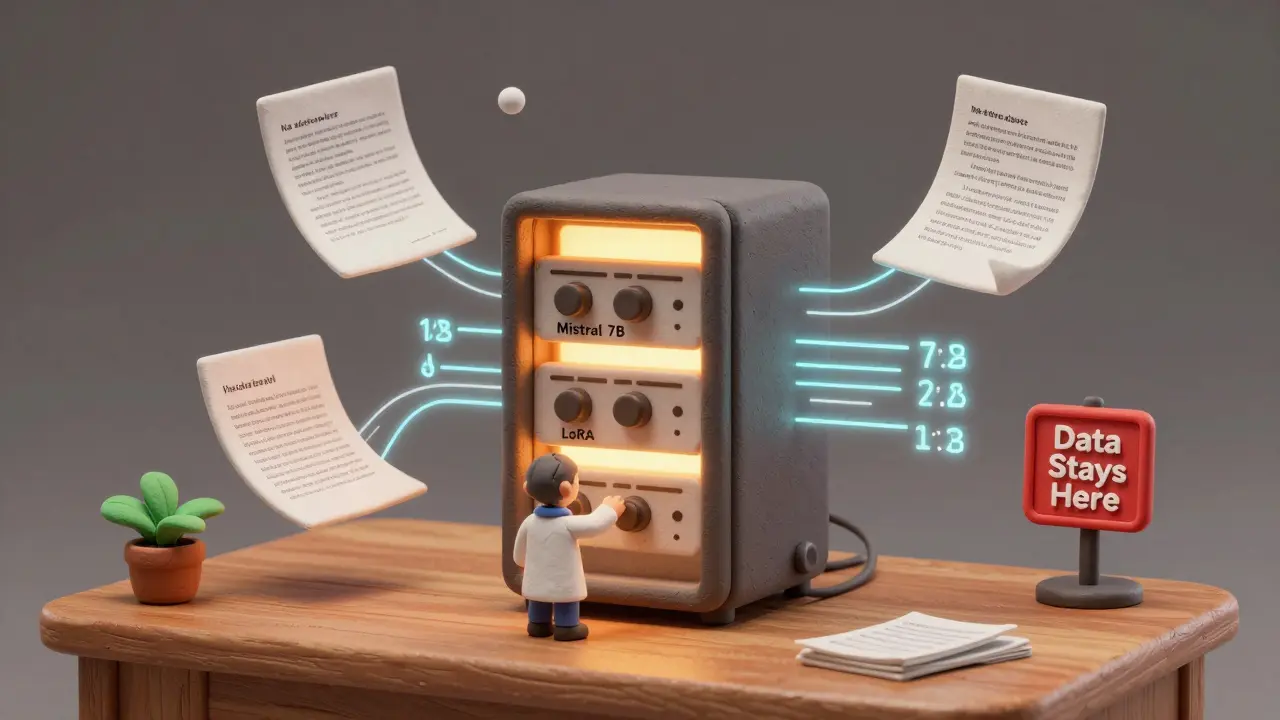

Prenons un exemple simple. Vous utilisez une API comme celle de OpenAI pour traiter des documents en français et en espagnol. Chaque requête coûte quelques cents. Ça paraît peu… jusqu’au moment où vous en faites 10 000 par jour. Soudain, vous payez des milliers de dollars par mois. Et en plus, vous ne pouvez pas stocker les données sur vos serveurs. Vos documents sensibles passent par un serveur externe. Vous n’avez aucune idée de comment le modèle a appris. Vous êtes à la merci de ses mises à jour, de ses blocages, de ses changements de tarifs. Les modèles open-source, comme Mistral 7B ou LLaMA 3, n’ont pas ce problème. Ils sont gratuits. Vous les téléchargez. Vous les faites tourner sur votre machine. Même sur un ordinateur portable récent. Pas de frais d’API. Pas de dépendance. Pas de risque de fuite de données. Et surtout : vous pouvez modifier leur comportement. Pas juste les paramètres. Le cœur même du modèle.Les modèles qui font la différence en 2026

Il ne s’agit pas de choisir n’importe quel modèle open-source. Certains sont conçus pour la recherche, d’autres pour l’industrie. Voici les trois qui dominent aujourd’hui :- Mistral 7B : Avec seulement 7 milliards de paramètres, il est léger, rapide, et étonnamment précis. Il excelle à générer des sorties structurées en JSON - idéal pour intégrer l’IA dans des systèmes de gestion de documents ou de facturation. Dans les tests, il a produit moins d’hallucinations que d’autres modèles, même avec des données complexes.

- LLaMA 3 : La version la plus récente de LLaMA, proposée par Meta, est disponible en trois tailles : 7 milliards, 13 milliards et 70 milliards de paramètres. Cela signifie que vous pouvez choisir un modèle adapté à votre infrastructure. Un petit serveur ? Utilisez la version 7B. Un data center ? La version 70B offre une puissance proche des modèles commerciaux les plus avancés.

- Phi-2 (Microsoft) : Ce modèle, avec seulement 2,7 milliards de paramètres, est conçu pour les appareils légers. Il fonctionne parfaitement sur un téléphone ou un dispositif IoT. Et pourtant, il rivalise avec des modèles bien plus gros sur des tâches de raisonnement logique et de compréhension multilingue.

Le site Hugging Face est devenu la bibliothèque centrale de ces modèles. Vous y trouvez des versions pré-entraînées, des adaptations spécifiques à la médecine, au droit, ou à la finance, et même des outils pour les tester en quelques clics.

Comment personnaliser un modèle sans être un expert en IA

Personnaliser un modèle, ce n’est plus réservé aux laboratoires de Google ou de Meta. Des outils simples ont rendu cette tâche accessible à n’importe quelle équipe technique.- LoRA (Low-Rank Adaptation) : Plutôt que de réentraîner tout le modèle (ce qui prend des semaines et des centaines de GPU), LoRA ne modifie qu’une petite partie du réseau. Cela réduit la mémoire nécessaire de 90 %. Vous pouvez faire une personnalisation complète sur un seul GPU 40 Go en quelques heures.

- RAG (Retrieval-Augmented Generation) : Imaginez que votre modèle ait accès à une base de données de contrats internes. Quand vous posez une question, il cherche d’abord les documents pertinents, puis il génère une réponse basée sur ces données. Résultat ? Moins d’erreurs, plus de précision, et une traçabilité totale.

- Ollama : Ce logiciel permet d’installer et de tester des modèles open-source directement sur votre Mac ou votre PC Windows. Pas besoin de cloud. Pas besoin de serveur. Vous testez une version quantifiée du modèle en 30 secondes. C’est comme un « brew » pour l’IA.

- LangChain : Il vous aide à assembler des chaînes de traitement : récupérer des données, les nettoyer, les envoyer au modèle, parser la réponse. Vous pouvez tester 5 méthodes de personnalisation en une journée.

Une entreprise de services financiers à Madison a utilisé cette combinaison pour créer un assistant juridique interne. Au lieu de payer 15 000 $/mois en API, ils ont utilisé Mistral 7B + LoRA + RAG sur un serveur local. Le coût total ? Moins de 2 000 $ pour l’infrastructure. Et le modèle comprend maintenant les termes spécifiques de leurs contrats. Les erreurs ont chuté de 78 %.

Les pièges à éviter - ce que personne ne vous dit

Ce n’est pas magique. Il y a des risques si vous ne faites pas attention.- Les licences : Certains modèles open-source, comme LLaMA 2, sont libres d’usage commercial. D’autres, comme certaines versions de Mistral, interdisent l’usage dans des secteurs réglementés. Lisez toujours la licence avant de déployer.

- La qualité des données : Un modèle mal entraîné est pire qu’un modèle inutilisable. Il donne des réponses crédibles… mais fausses. Si vous voulez qu’il comprenne la terminologie médicale, vous avez besoin de milliers d’exemples précis. Des données générées par un autre modèle ne suffisent pas. Il faut des experts pour valider.

- La sur-optimisation : Un modèle trop personnalisé devient rigide. Il ne sait plus répondre à des questions hors de son domaine. Il faut un équilibre entre spécialisation et flexibilité.

Un cas concret : Comment une entreprise a triplé sa précision en 3 étapes

Emburse, une entreprise de gestion de dépenses, a mené une série d’expériences pour améliorer son assistant de facturation multilingue.- Itération 1 : 5 000 exemples manuellement étiquetés en anglais. Modèle : Mistral 7B. Résultat : 62 % de précision sur les informations clés (montants, dates, comptes).

- Itération 2 : 20 000 exemples en anglais, espagnol et français. Utilisation de LLM pour générer des étiquettes secondaires. Résultat : 81 % de précision. Le modèle comprenait désormais les variations linguistiques.

- Itération 3 : Plus de 50 000 exemples, avec des données générées par un modèle multimodal (texte + images de factures). Résultat : 93 % de précision. Les hallucinations ont chuté de 85 %. Le modèle pouvait désormais extraire des données de factures scannées avec une fiabilité proche d’un humain.

Ce n’est pas une question de puissance brute. C’est une question de méthode. Chaque itération a ajouté de la diversité, de la qualité, et de la pertinence. Et chaque étape a été rendue possible par l’accès au code et aux données.

Pourquoi choisir l’open-source en 2026 ?

Si vous êtes une startup, un laboratoire, ou une PME qui traite des données sensibles, l’open-source n’est plus une option technique. C’est une nécessité stratégique.- Coût : Plus d’API. Plus de frais cachés. Votre modèle tourne sur votre infrastructure. Vous payez une fois, vous utilisez à l’infini.

- Contrôle : Vous décidez quand et comment le modèle évolue. Pas un fournisseur. Pas une politique de mise à jour. Vous.

- Transparence : Vous voyez comment il fonctionne. Vous pouvez vérifier les biais. Vous pouvez auditer les décisions. Dans la santé, la finance, ou le droit, c’est crucial.

- Évolutivité : Un modèle de 7 milliards de paramètres peut tourner sur un serveur de 10 000 $. Un modèle de 70 milliards peut être déployé sur un cluster. Vous choisissez l’échelle.

Les grands fournisseurs veulent que vous restiez dans leur écosystème. Ils vous rendent dépendant. Les modèles open-source vous rendent libre.

Et maintenant ? Comment commencer

Si vous voulez essayer, voici les 3 premières étapes :- Téléchargez Ollama sur votre ordinateur.

- Installez Mistral 7B ou LLaMA 3 avec la commande :

ollama run mistral. - Testez-le avec une question simple : "Explique-moi la différence entre un contrat de vente et un contrat de prestation de services en français."

Vous verrez que la réponse est déjà meilleure que celle d’un modèle commercial. Et vous n’avez rien payé. Vous n’avez rien partagé. Vous avez juste commencé.

Quelle est la différence entre un modèle open-source et un modèle open-weight ?

Un modèle open-source donne accès à l’architecture, aux poids, aux données d’entraînement et au code. Vous pouvez tout modifier. Un modèle open-weight, lui, ne vous donne que les poids (les paramètres entraînés), mais garde cachés l’architecture et les données. Cela permet de faire du fine-tuning plus vite, mais pas de réelle personnalisation profonde. Mistral 7B est open-source. Certains modèles de Hugging Face sont open-weight.

Puis-je vraiment faire tourner un modèle de 70 milliards de paramètres sur un ordinateur personnel ?

Non, pas en version complète. Mais vous pouvez utiliser des versions quantifiées - par exemple, en 4-bit ou 8-bit. Ces versions réduisent la taille du modèle de 75 % sans perte significative de performance. Avec Ollama ou llama.cpp, vous pouvez faire tourner une version quantifiée de LLaMA 3 70B sur un MacBook Pro récent. Cela prend environ 20 Go de RAM. C’est lent, mais c’est possible.

Les modèles open-source sont-ils aussi précis que GPT-4 ou Claude 3 ?

Sur des tâches générales, oui, certains comme LLaMA 3 ou Mistral 7B rivalisent avec GPT-4. Sur des tâches spécialisées - comme comprendre la terminologie médicale ou juridique - ils peuvent les surpasser, car ils sont personnalisés pour votre domaine. Leur force n’est pas d’être « meilleurs » en général, mais d’être « plus précis » pour vous.

Quels sont les meilleurs outils pour créer des données d’entraînement personnalisées ?

Utilisez un modèle LLM pour générer des exemples synthétiques, puis faites-les valider par des experts. Des outils comme Dask permettent de traiter des milliers d’exemples en parallèle. Une entreprise a généré 25 000 exemples de contrats en 4 heures en utilisant Mistral 7B + Dask, puis a fait relire les 5 % les plus critiques par ses juristes. C’est plus rapide et moins cher que de tout annoter manuellement.

Est-ce que les modèles open-source sont sécurisés ?

Ils sont plus sécurisés que les API, car vos données ne quittent pas votre serveur. Mais ils ne sont pas intrinsèquement « sécurisés ». Si vous les exposez à Internet sans protection, ils peuvent être piratés. Comme n’importe quel logiciel, ils doivent être configurés avec des pare-feux, des authentifications, et des mises à jour. Le contrôle total implique aussi la responsabilité totale.