Quand vous posez une question à un système d'intelligence artificielle, il ne suffit pas de dire "Comment fonctionne le système solaire?" pour obtenir une bonne réponse. Beaucoup de systèmes RAG (Retrieval-Augmented Generation) échouent simplement parce que la requête est trop vague, trop courte, ou mal formulée. Ce n'est pas le modèle qui est mauvais - c'est la requête qui ne lui donne pas assez d'indices. C'est là que la compréhension des requêtes entre en jeu.

Pourquoi la requête initiale ne suffit pas

Imaginons que vous demandiez à un assistant : "Qu'est-ce que le Bitcoin?". Un système RAG simple va chercher des documents contenant les mots "Bitcoin". Mais si vous posez "Pourquoi Bitcoin est-il cher?", le système peut rater des documents qui parlent de l'offre limitée, de la demande des investisseurs, ou de la minage. Il ne comprend pas que "cher" signifie "à haut prix", "valeur élevée" ou "coûteux". Il ne voit pas la relation entre "coût" et "valeur de marché". Les études de l'Université de Stanford en février 2024 ont montré que jusqu'à 48 % des requêtes utilisateur dans les systèmes RAG de base conduisent à une récupération de documents inutiles. Ce n'est pas une erreur de l'IA. C'est une erreur de communication. L'IA ne pense pas comme un humain. Elle ne devine pas. Elle suit des motifs. Si vous ne lui donnez pas les bons motifs, elle ne trouvera pas les bonnes réponses.Comment transformer une mauvaise requête en une bonne

La compréhension des requêtes pour RAG repose sur deux techniques principales : la reformulation et l'expansion. La reformulation, c'est reformuler la question pour la rendre plus précise. Par exemple :- Requête originale : "Quels sont les effets du café?"

- Reformulation : "Quels sont les effets physiologiques de la caféine sur le système nerveux central chez les adultes?"

- "cryptomonnaie décentralisée"

- "monnaie numérique sans banque centrale"

- "actif numérique basé sur la blockchain"

Les trois piliers d'un système de compréhension de requête

Un système efficace de compréhension de requête a trois composants :- L'analyseur de requête : Il décompose la phrase. Il identifie les entités (noms propres, dates, concepts), les verbes d'action, et les relations entre les mots. Par exemple, dans "Quels sont les risques de l'IA dans les soins médicaux?", il repère "risques", "IA", et "soins médicaux" comme éléments clés.

- Le transformateur de requête : C'est là que les techniques de reformulation et d'expansion s'appliquent. Il peut générer 2 à 5 variantes de la question, en utilisant des modèles légers (environ 110 millions de paramètres) qui tournent même sur un CPU. Selon NVIDIA, cela ajoute seulement 150 à 300 millisecondes au temps total de traitement.

- Le validateur de requête : Il évalue les variantes. Il élimine celles qui sont trop larges, trop redondantes, ou qui introduisent des biais. Par exemple, si une expansion ajoute "Bitcoin est une arnaque", le validateur la supprime.

Les techniques les plus efficaces aujourd'hui

Plusieurs méthodes ont prouvé leur efficacité en 2024 :- Reformulation multi-requête : Génère plusieurs versions de la question, puis cherche simultanément dans la base de données. Une étude de l'Université de Washington montre qu'elle augmente la récupération de documents pertinents de 37,2 % par rapport à une seule requête.

- Step-back prompting : Au lieu de répondre directement, le système se demande d'abord : "Quels sont les principes fondamentaux derrière cette question?". Par exemple, pour "Pourquoi les taux d'intérêt augmentent-ils?", il reformule en "Quels sont les facteurs économiques qui influencent les taux d'intérêt?". Google AI a montré que cela améliore la précision factuelle de 29,8 % pour les questions complexes.

- Requête basée sur un graphe de connaissances : Stanford a développé une méthode qui représente la question comme un graphe de concepts interconnectés. Cela permet de relier "diabète" à "insuline", "glycémie", "régime alimentaire", etc., même si ces mots n'apparaissent pas dans la question originale. Cette méthode a amélioré la performance de 41,7 % sur les requêtes complexes.

Quand ça ne sert à rien

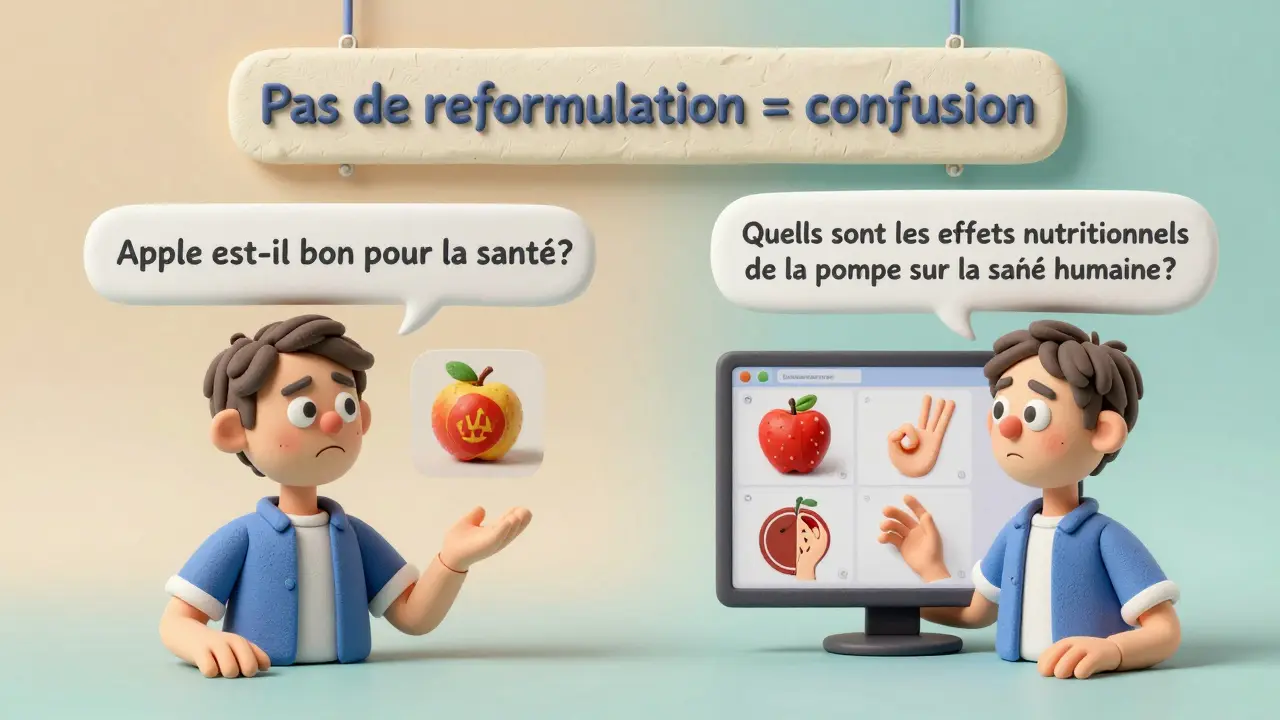

Ce n'est pas une solution magique. Pour une question simple comme "Quelle est la population de Paris?", la reformulation est inutile. Le système peut déjà trouver la réponse avec un simple mot-clé. L'expansion ajoute seulement du bruit et consomme plus de ressources. Microsoft Research a analysé 15 000 requêtes et constaté que les gains de précision avec la compréhension de requête sont négligeables pour les questions à réponse unique, directe, et factuelle. Les avantages apparaissent vraiment quand :- La question est ambiguë : "Apple est-il bon pour la santé?" - Apple la marque ou la pomme?

- Il y a plusieurs facettes : "Quels sont les impacts de l'IA sur l'emploi?"

- Le domaine est technique : "Comment fonctionne le protocole TLS 1.3?"

Les pièges à éviter

Les développeurs qui ont intégré ces systèmes ont appris à leurs dépens :- Trop d'expansion = trop de bruit : Une étude de Towards Data Science montre que 78 % des développeurs ont trouvé que 2 à 3 variantes de requête étaient optimales. Au-delà, les résultats deviennent moins pertinents.

- Les biais s'accumulent : Dr. Emily Bender a montré qu'en étendant une requête juridique avec des termes historiques, le système a récupéré plus de cas de préjugés raciaux dans les décisions judiciaires. L'expansion amplifie les biais existants dans les données.

- La complexité augmente les coûts : Selon une enquête de Towards Data Science, implémenter ces techniques demande 35 à 50 % plus de temps de développement. Un ingénieur de Spotify a passé 3 mois pour classer 147 types de requêtes dans son système de recommandation musicale.

- Le débogage devient plus difficile : 65 % des développeurs sur GitHub ont signalé qu'il était plus dur de comprendre pourquoi un système a échoué quand il y a plusieurs versions de requête en jeu.

Comment commencer

Si vous avez déjà un système RAG de base, voici comment intégrer la compréhension de requête sans tout réécrire :- Commencez avec la reformulation multi-requête. C'est la plus simple à implémenter. LangChain offre des exemples prêts à l'emploi.

- Testez sur 100 requêtes réelles de vos utilisateurs. Vérifiez si les documents récupérés sont plus pertinents.

- Utilisez un validateur simple : éliminez les variantes qui contiennent des mots négatifs ou contradictoires.

- Surveillez la consommation de tokens. Une requête étendue peut consommer 2,7 fois plus de tokens qu'une requête simple - ce qui augmente les coûts sur des plateformes comme OpenAI.

- Intégrez le système étape par étape. NVIDIA recommande 2 à 3 semaines pour une intégration complète après la mise en place de base.

Le futur est déjà là

En 2026, 87 % des analystes de Gartner prédisent que la compréhension de requête sera une composante standard de tout système RAG professionnel. Les entreprises dans la santé (68 %), le juridique (61 %), et les services financiers (54 %) l'ont déjà adoptée. Ce n'est plus une option pour les prototypes - c'est une exigence pour les systèmes fiables. Mais attention : ce n'est pas une course à la complexité. Le but n'est pas de faire la requête la plus longue. Le but est de faire la requête la plus utile. Une bonne requête, c'est une question claire, précise, et riche en contexte - pas une liste de synonymes. Les systèmes qui réussissent ne sont pas ceux qui utilisent les techniques les plus avancées. Ce sont ceux qui comprennent leur utilisateur. Et pour comprendre l'utilisateur, il faut d'abord comprendre sa question.Qu'est-ce que la reformulation de requête dans RAG?

La reformulation de requête consiste à rephraser la question de l'utilisateur pour la rendre plus précise, plus complète, ou plus adaptée à la base de données. Par exemple, transformer "Pourquoi le café fait du mal?" en "Quels sont les effets négatifs de la caféine sur la santé à long terme?". Cela permet au système de recherche de trouver des documents plus pertinents, même si les mots exacts ne correspondent pas.

L'expansion de requête augmente-t-elle toujours la précision?

Non. L'expansion aide quand la question est ambiguë ou complexe, mais elle peut nuire pour les questions simples. Par exemple, étendre "Quelle est la capitale de la France?" avec "Paris ville France" ou "ville principale France" n'apporte rien - et peut même introduire des erreurs si les variantes sont mal choisies. Il faut équilibrer étendre et valider.

Faut-il un GPU puissant pour implémenter la compréhension de requête?

Non. Les modèles de transformation de requête sont légers - environ 110 millions de paramètres. Ils peuvent tourner sur une GPU d'entrée de gamme comme l'NVIDIA T4, ou même sur un CPU avec une latence de 200 à 400 ms. Ce n'est pas la puissance qui compte, c'est la qualité de la transformation.

Quels sont les meilleurs outils pour commencer?

LangChain v2.1 (juillet 2024) propose des modules prêts à l'emploi pour la reformulation multi-requête et le step-back prompting. NVIDIA RAG Stack 2.0 offre une transformation adaptative automatique. Pour les débutants, commencez avec LangChain : sa documentation est claire, et ses exemples fonctionnent avec peu de code.

Est-ce que la compréhension de requête réduit les hallucinations de l'IA?

Oui, indirectement. En récupérant des documents plus pertinents, le modèle a moins tendance à inventer des réponses. L'étude de Google AI montre que le step-back prompting améliore la précision factuelle de 29,8 %. Dans les applications médicales, Stanford a observé une réduction de 33,7 % des hallucinations grâce à cette technique.

Combien de temps faut-il pour intégrer cette fonctionnalité?

Pour une base simple, 8 à 12 heures de formation suffisent pour implémenter la reformulation multi-requête. Pour des systèmes avancés avec routage adaptatif, comptez 40 à 60 heures. NVIDIA recommande 2 à 3 semaines d'intégration complète après la mise en place de base RAG.

Quels secteurs bénéficient le plus de cette technique?

Les secteurs à haute densité de connaissances : la santé (68 % d'adoption), le juridique (61 %), et les services financiers (54 %). Ces domaines traitent des questions complexes, ambiguës, et à fort enjeu - où une mauvaise réponse peut avoir de graves conséquences. C'est là que la compréhension de requête fait la plus grande différence.