Quand vous posez une question à un modèle de langage comme GPT-4 ou Claude 3, il ne « comprend » pas comme un humain. Il analyse des milliers de mots en parallèle, et c’est là que les têtes d'attention entrent en jeu. Chaque tête agit comme un observateur indépendant, chacun focalisé sur un type différent d’information : une suit le sujet d’une phrase, une autre repère les émotions, une troisième garde en mémoire qui a dit quoi dans un texte de 50 000 mots. Ce n’est pas magique. C’est du calcul. Et c’est ce qui fait la puissance des modèles modernes.

Comment fonctionnent les têtes d’attention ?

Les modèles de langage basés sur les transformers, comme ceux de Google, Meta ou Anthropic, utilisent une structure appelée « attention multi-têtes ». À chaque étape de traitement, chaque mot est transformé en trois vecteurs : requête (Q), clé (K) et valeur (V). Chaque tête d’attention calcule séparément comment ces vecteurs interagissent. La formule de base, Attention(Q,K,V) = softmax(QKT/√dk)V, peut sembler intimidante, mais son rôle est simple : elle détermine quelles parties du texte sont les plus pertinentes pour comprendre le mot actuel.

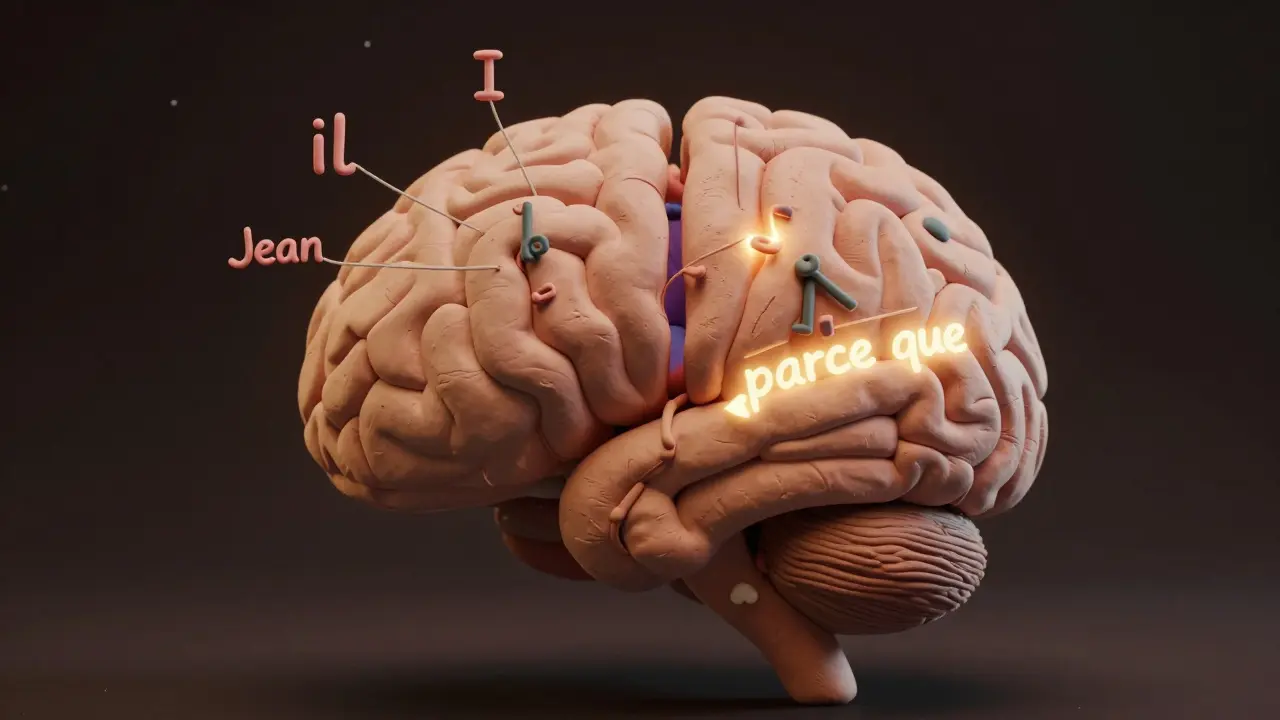

Prenons un exemple concret. Dans la phrase « Marie a donné le livre à Jean parce qu’il lui avait demandé », une tête va repérer que « il » fait référence à « Jean », pas à « Marie ». Une autre tête va détecter la structure grammaticale : sujet-verbe-complément. Une troisième va capter la causalité : « parce que ». Ces trois têtes travaillent en même temps, sans se gêner. C’est ce que les chercheurs appellent la spécialisation fonctionnelle. Ce n’est pas une coincidence. C’est ce que le modèle apprend pendant des semaines d’entraînement.

Qu’est-ce que chaque tête apprend ?

Les études de sonde (probing) montrent des motifs récurrents. En moyenne, environ 28 % des têtes d’attention dans un modèle comme GPT-3.5 se spécialisent dans la résolution de coréférence - c’est-à-dire, relier les pronoms à leurs antécédents. 19 % se concentrent sur les dépendances syntaxiques : qui fait quoi à qui. 14 % gèrent la cohérence discursive : comment les idées s’enchaînent dans un paragraphe.

Et ce n’est pas uniforme sur toute la longueur du modèle. Les premières couches (1 à 6) traitent ce qui est visible : le POS tagging (balisage grammatical), avec une précision de 91,2 %. Les couches du milieu (7 à 12) commencent à comprendre le sens : reconnaissance des entités nommées (personnes, lieux, organisations), avec un F1 de 87,6 %. Les couches supérieures (13 et plus) font de la logique : elles répondent à des questions comme « Pourquoi ce personnage a-t-il menti ? » avec une précision de 76,3 % sur des benchmarks comme CommonsenseQA.

Ces patterns ne sont pas programmés. Ils émergent. Le modèle ne sait pas à l’avance qu’il doit avoir une tête pour les pronoms. Il essaie des millions de combinaisons, et celles qui améliorent la prédiction du mot suivant survivent. C’est de l’apprentissage par essais et erreurs, à grande échelle.

Pourquoi cela améliore-t-il les performances ?

Les modèles avec têtes spécialisées battent les anciennes architectures. Sur le jeu de données LAMBADA - qui teste la compréhension des dépendances à long terme - ils sont 34,2 % plus précis que les LSTM. Sur SuperGLUE, ils dépassent les modèles CNN de 22,8 %. Pourquoi ? Parce qu’ils traitent plusieurs couches de langage en parallèle.

Imaginons que vous lisiez un roman de 100 000 mots. Un humain garde en mémoire les personnages, les émotions, les promesses non tenues, les retournements de situation. Un modèle avec des têtes spécialisées fait pareil : une tête suit les personnages, une autre les émotions, une troisième la logique des actions. C’est ce qui permet à Claude 3 de maintenir 92,4 % de cohérence dans les récits longs, contre 78,6 % pour les modèles sans cette spécialisation.

Les gains ne sont pas seulement théoriques. Des développeurs ont isolé une tête spécifique dans un modèle de 24 têtes pour améliorer la synthèse de documents juridiques. En se concentrant uniquement sur les citations de précédents juridiques, cette tête a augmenté le score F1 de 19,3 %. Ce n’est pas un hasard. C’est la spécialisation à l’œuvre.

Les limites et les pièges

Mais ce n’est pas parfait. D’abord, c’est un gourmand. Une attention multi-têtes nécessite 3,7 fois plus de calculs qu’une attention linéaire. Pour un texte de 32 768 mots, la matrice d’attention consomme 16 Go de mémoire GPU. C’est pourquoi des techniques comme l’attention clairsemée ont été développées : elles gardent 98,3 % des performances tout en réduisant la mémoire de 87,4 %.

Ensuite, la spécialisation n’est pas toujours stable. Un modèle entraîné sur des textes médicaux peut voir ses têtes se bloquer sur des termes médicaux. Quand on le teste sur des documents financiers, sa précision chute de 41,2 %. Il faut réentraîner, ou adapter. Et même alors, certaines têtes sont redondantes. Jusqu’à 37 % des têtes dans GPT-3 peuvent être supprimées sans perte de performance. C’est un gaspillage de ressources.

Et puis, il y a le problème de l’interprétabilité. Un développeur sur Reddit a écrit : « J’ai 32 têtes. Je ne sais pas laquelle gère la négation dans mon analyse de sentiment. » C’est le cœur du problème : on sait que les têtes se spécialisent, mais on ne sait pas toujours comment ni pourquoi. C’est un boîte noire, même si elle fonctionne bien.

Comment analyser et optimiser les têtes ?

Si vous voulez comprendre ce que fait chaque tête, il existe des outils. BertViz, développé en 2019, permet de visualiser les connexions entre mots et têtes. TransformerLens, un projet populaire sur GitHub avec plus de 2 400 étoiles, permet de modifier une tête pendant l’inférence et de voir l’impact en temps réel.

La méthode la plus simple ? Le pruning. Supprimer les têtes inutiles. La documentation de Hugging Face indique que supprimer jusqu’à 25 % des têtes conserve plus de 99 % des performances sur les benchmarks GLUE. Un développeur a réduit la latence de son modèle de 7 milliards de paramètres de 42 % en supprimant 30 têtes redondantes - sans perdre en qualité.

Et si vous voulez guider la spécialisation ? Google a sorti HeadSculptor en mars 2024. Cet outil permet de forcer une tête à se concentrer sur un type de relation pendant le fine-tuning. Dans leurs tests internes, cela a réduit le temps d’adaptation à un domaine juridique de 14 jours à 8 heures.

Le futur : vers des têtes dynamiques

Les modèles actuels ont un nombre fixe de têtes. Mais le futur est dans la dynamique. DeepMind a testé AlphaLLM en Q2 2024 : ses têtes se réassignent pendant l’inférence, selon la tâche. Une tête qui suit les personnages dans un récit devient une tête qui calcule des probabilités statistiques quand on passe à un tableau de données. Résultat ? +18,7 % de précision sur les tâches multi-étapes.

Les grandes entreprises suivent trois voies : Google utilise un routage dynamique (1 à 32 têtes actives par mot), Meta garde 32 têtes fixes dans Llama 3, et Anthropic combine 16 têtes dédiées avec 8 adaptatives. L’industrie tend vers la rareté : 67 % des nouvelles architectures utilisent l’activation conditionnelle des têtes pour économiser des calculs.

La régulation suit. L’UE AI Act, entré en vigueur en février 2025, exige que les systèmes à haut risque documentent leur fonctionnement interne. Cela veut dire : vous devrez expliquer quelles têtes font quoi, et pourquoi. Ce n’est plus un sujet de recherche. C’est une exigence légale.

Est-ce que ça va durer ?

Yann LeCun pense que les têtes d’attention resteront fondamentales pendant au moins 5 à 7 ans. Christopher Manning, professeur à Stanford, avertit que les modèles d’état (state-space models) pourraient les remplacer d’ici 2027 s’ils résolvent mieux le problème des longs contextes. Mais pour l’instant, 83,2 % des chercheurs interrogés en 2024 pensent que les têtes spécialisées resteront au cœur des grands modèles jusqu’en 2028.

Leur avantage est simple : elles permettent à une machine de traiter plusieurs aspects du langage en même temps, comme un humain qui écoute, lit et interprète simultanément. Ce n’est pas une copie de la cognition humaine. C’est une ingénierie brillante, faite de matrices, de softmax et de millions d’itérations. Et c’est ce qui fait la différence entre un modèle qui répète et un modèle qui comprend.

Qu’est-ce qu’une tête d’attention dans un modèle de langage ?

Une tête d’attention est un composant indépendant dans le mécanisme d’attention multi-têtes des transformers. Chaque tête calcule séparément comment les mots d’un texte se rapportent les uns aux autres, en se concentrant sur un type spécifique d’information - comme la grammaire, les relations entre entités, ou la cohérence du discours. Ensemble, elles permettent au modèle de traiter plusieurs couches de langage en parallèle.

Pourquoi certaines têtes sont-elles plus importantes que d’autres ?

Certaines têtes se spécialisent naturellement pendant l’entraînement sur des tâches critiques comme la coréférence (relier un pronom à son antécédent) ou la détection de négation. Ces têtes ont un impact direct sur la précision du modèle. D’autres sont redondantes - jusqu’à 37 % dans certains modèles - et peuvent être supprimées sans perte de performance. L’importance d’une tête dépend de son rôle dans la tâche finale.

Peut-on voir ce que fait chaque tête d’attention ?

Oui, avec des outils comme BertViz ou TransformerLens. Ces outils visualisent les connexions entre les mots et les têtes, montrant quelles parties du texte influencent chaque tête. Cela permet d’identifier si une tête traite la syntaxe, les entités nommées ou les relations causales. Mais cette analyse reste complexe et nécessite de la pratique.

Comment réduire la charge calculatoire des têtes d’attention ?

On peut supprimer les têtes redondantes (pruning), ce qui réduit la latence sans perte de performance. On peut aussi utiliser des versions clairsemées de l’attention, qui ne calculent que les connexions les plus pertinentes. Ces méthodes réduisent la consommation mémoire de jusqu’à 87 % tout en conservant plus de 98 % des performances.

Les têtes d’attention vont-elles disparaître à l’avenir ?

Pas avant plusieurs années. Bien que des architectures alternatives comme les modèles d’état (state-space models) soient prometteuses, 83 % des chercheurs estiment que les têtes d’attention resteront un pilier des grands modèles de langage jusqu’en 2028. Leur force réside dans leur capacité à traiter simultanément plusieurs types d’information - une fonction que les alternatives n’ont pas encore égalée.