Vous avez déjà vu un produit en ligne qui semble parfait… jusqu’à ce que vous ouvriez la version en espagnol d’Espagne et que vous tombiez sur un « ¡Qué chévere! » dans un contexte médical. Ou pire : un message marketing en japonais qui utilise un ton trop familier pour un public d’entreprises. Ce n’est pas une erreur de traduction. C’est une erreur de localisation. Et l’IA générative, si elle n’est pas bien guidée, peut la reproduire à grande échelle.

La localisation, ce n’est pas juste traduire

Traduire, c’est remplacer un mot par un autre. Localiser, c’est adapter le sens, le ton, les références culturelles, les unités de mesure, les couleurs, les images, les symboles - tout ce qui fait que le contenu résonne chez un public local. Un slogan qui marche en France peut sembler offensant en Arabie Saoudite. Une icône de « panier » en Amérique du Nord peut être interprétée comme un sac à main en Inde. Et l’IA générative, si on lui demande simplement « traduis ça en allemand », va faire exactement ça : traduire. Pas localiser.C’est là que les prompts de localisation entrent en jeu. Ce ne sont pas des instructions vagues comme « rends ça plus naturel ». Ce sont des directives précises, structurées, qui disent à l’IA : « Tu es un traducteur senior spécialisé dans les logiciels B2B pour le marché brésilien. Voici le glossaire officiel. Le ton doit être professionnel mais pas froid. Évite les anglicismes. Utilise le pronom « você » et non « senhor ». Et vérifie que les références culturelles sont adaptées. »

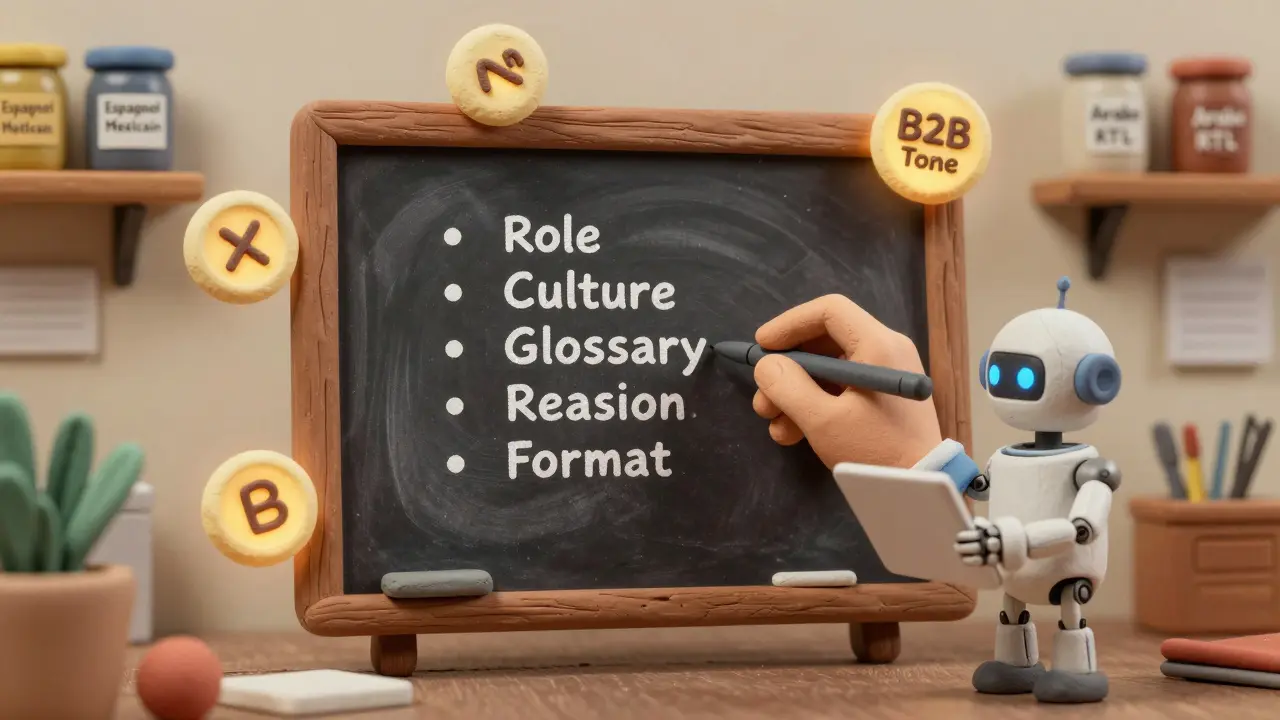

Les six composantes d’un bon prompt de localisation

Les équipes de localisation qui réussissent avec l’IA utilisent des prompts qui contiennent six éléments clés. Sans eux, vous obtenez des traductions correctes… mais culturellement maladroites.- Rôle explicite : « Vous êtes un spécialiste de la localisation pour le marché japonais, avec 15 ans d’expérience dans les applications mobiles. »

- Contexte culturel : « Le public cible est composé de professionnels âgés de 35 à 55 ans, dans les grandes villes. Les références à la famille ou à la hiérarchie doivent être respectueuses. »

- Glossaire obligatoire : « Utilise exclusivement les termes suivants : ‘interface utilisateur’ → ‘UI’, ‘connexion’ → ‘connexion’, ‘synchronisation’ → ‘synchronisation’. »

- Processus de réflexion : « Avant de traduire, analyse d’abord les risques culturels, puis les incohérences terminologiques, puis propose la version finale. »

- Format de sortie : « Renvoie uniquement le texte traduit, sans explications. Si tu n’es pas sûr, indique « [À vérifier humainement] ».

- Contraintes techniques : « Respecte la limite de 200 caractères pour les boutons. Utilise des guillemets français (« ») et non anglo-saxons (" "). »

Un prompt bien construit réduit les erreurs de localisation de 32 à 47 %, selon des études de Seatongue. Il fait aussi gagner jusqu’à 65 % de temps sur les campagnes globales. Mais il faut le concevoir comme un contrat - pas comme une suggestion.

Quel modèle choisir ? GPT-4 Turbo, Claude 3 ou Mistral 7B ?

Tous les modèles d’IA ne sont pas égaux pour la localisation. Le choix dépend de ce que vous traduisez.| Modèle | Meilleur pour | Coût (par million de tokens) | Limites |

|---|---|---|---|

| GPT-4 Turbo | Transcréation, marketing, contenu créatif | 10 $ | Moins précis pour la terminologie technique |

| Claude 3 | Documents longs, cohérence globale | 15 $ | Peut ignorer les nuances de genre dans certaines langues |

| Mistral 7B | Coût faible, projets internes | 0 $ (hébergement inclus) | Moins bon pour les langues rares ou à écriture droite-gauche |

Les moteurs de traduction automatique spécialisés (NMT) restent meilleurs pour les manuels techniques ou les documents juridiques - ils ont une précision de 85 % contre 72 % pour GPT-4 Turbo. Mais pour du contenu marketing, des vidéos, des sites e-commerce, les modèles comme GPT-4 Turbo surpassent les NMT en créativité et en adaptation culturelle. La clé ? Ne pas choisir un modèle, mais associer les outils.

Les pièges courants - et comment les éviter

Même les meilleurs prompts peuvent échouer si vous ignorez ces erreurs récurrentes.- Ignorer les dialectes : « Espagnol » n’existe pas en tant que langue unique. Le même mot pour « ordenador » en Espagne est « computadora » en Amérique latine. Un prompt doit spécifier : « Utilise l’espagnol mexicain, pas l’espagnol d’Espagne. »

- Ne pas gérer les langues à écriture droite-gauche : L’arabe, le persan, l’hébreu… beaucoup d’IA confondent l’ordre des mots ou les espaces. Testez toujours avec un locuteur natif.

- Ne pas intégrer les glossaires : Un prompt sans glossaire = une traduction aléatoire. Intégrez votre base de termes dans le prompt via RAG (retrieval-augmented generation). C’est ce que font les plateformes comme Lokalise ou Phrase.

- Ne pas tester en contexte : Un prompt qui marche sur un court texte peut échouer sur un paragraphe de 500 mots. Testez toujours avec des contenus réels, pas des exemples.

- Ne pas avoir de validation humaine : L’IA fait des erreurs. 15 % d’erreurs dans un document médical ou juridique, c’est un risque légal. Même avec un prompt parfait, gardez un humain pour valider les contenus critiques.

Un client automobile a perdu 287 000 $ en 2024 parce qu’un prompt n’a pas spécifié que « réparation » ne devait pas être utilisé dans les pays du Golfe - le mot avait une connotation négative liée à la perte de valeur. Ce n’est pas une erreur technique. C’est une erreur de culture.

Comment mettre en place un workflow humain + IA

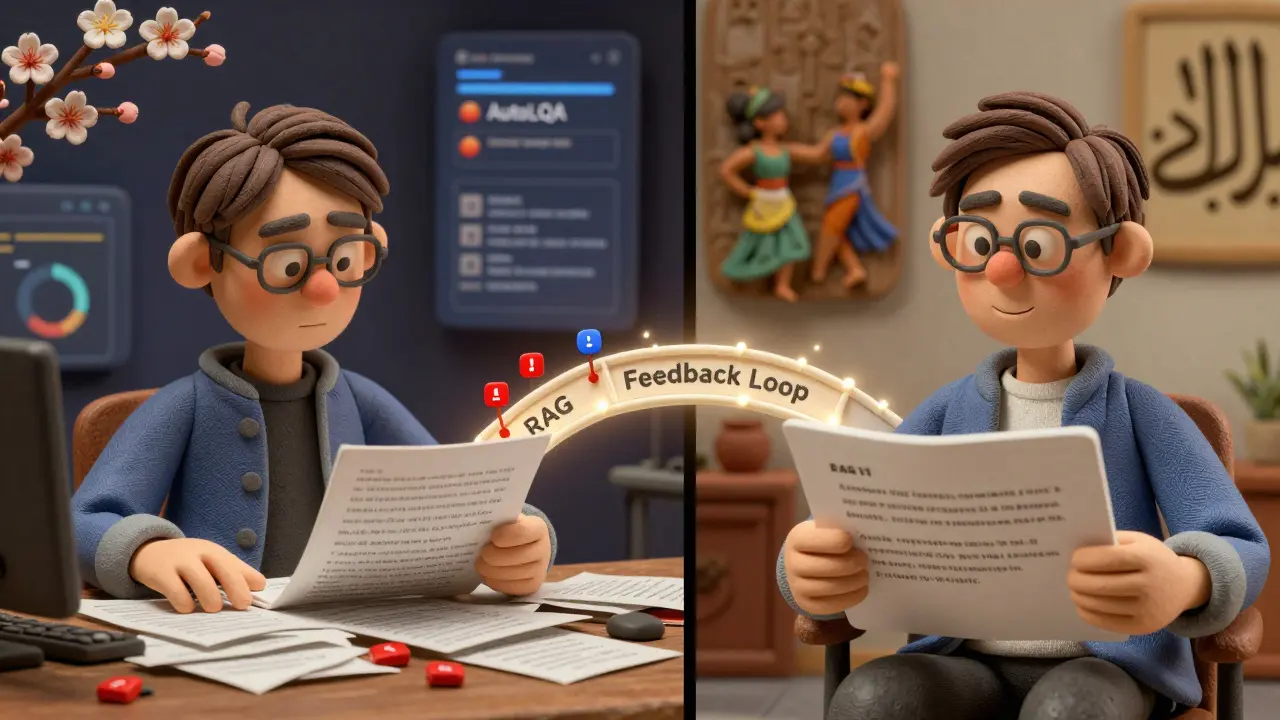

La meilleure approche n’est pas de remplacer les traducteurs. C’est de les renforcer.Voici un workflow testé par Seatongue et d’autres entreprises :

- Étape 1 : L’IA génère la première version avec un prompt de localisation structuré.

- Étape 2 : Un outil comme AutoLQA (intégré dans Lokalise) analyse automatiquement les erreurs de terminologie, de style, de format.

- Étape 3 : Seuls les segments avec un score de confiance bas ou un risque culturel élevé sont envoyés à un traducteur humain.

- Étape 4 : Le traducteur corrige, puis ajoute des feedbacks au prompt pour l’améliorer (ex. : « Ajoute cette règle : dans le marché brésilien, évite les verbes à l’impératif pour les produits de luxe »).

- Étape 5 : Le prompt mis à jour est utilisé pour la prochaine campagne.

Ce système permet de traiter 12 000 diapositives en 8 langues en 3 semaines, contre 10 semaines avec un processus entièrement humain. Et la qualité est meilleure.

Les compétences qui comptent en 2025

Il n’y a plus de « traducteur » ou de « développeur » dans la localisation. Il y a des ingénieurs de prompts.En 2024, 74 % des équipes de localisation ont dit que comprendre la tokenisation des modèles d’IA était la partie la plus difficile à maîtriser. Ce n’est pas une question de code. C’est une question de logique : combien de mots votre prompt contient-il ? Est-ce que l’IA « oublie » la première partie quand elle lit la dernière ?

Les meilleurs profils aujourd’hui sont ceux qui comprennent à la fois :

- Les nuances linguistiques (genre, registre, dialectes)

- Les contraintes techniques (longueur de contexte, tokens, RAG)

- Les normes de conformité (GDPR, RGPD, restrictions d’exportation)

Les entreprises recrutent maintenant des « spécialistes en localisation IA » - un poste qui n’existait pas il y a deux ans. Et ils paient jusqu’à 185 $/heure pour ces compétences.

Et après ? Ce qui vient en 2026

D’ici 2026, 75 % des entreprises utilisent l’ingénierie de prompts comme standard dans leur localisation. Les outils vont devenir plus intelligents :- Des bibliothèques de prompts pré-validés (comme PromptBank de Lionbridge, avec 8 500 prompts prêts à l’emploi)

- Des prompts qui analysent des images et du texte en même temps (ex. : « Ce bouton rouge en Chine signifie chance, mais en Russie, il signifie danger »)

- Des systèmes qui apprennent des corrections humaines pour améliorer automatiquement les prompts futurs

Le futur de la localisation n’est pas dans la traduction automatique. C’est dans la localisation intelligente - où l’IA fait le travail de base, et les humains se concentrent sur ce que l’IA ne comprend pas encore : la culture, l’émotion, le contexte.

La question n’est plus : « L’IA peut-elle traduire ? »

La question est : « Pouvez-vous lui dire comment localiser ? »

Quelle est la différence entre traduction et localisation avec l’IA ?

La traduction change les mots d’une langue à une autre. La localisation adapte le sens, le ton, les références culturelles, les symboles et même les formats (dates, devises, unités). L’IA peut traduire automatiquement, mais elle ne localise que si vous lui donnez des instructions précises - un prompt bien conçu - qui lui disent comment penser comme un locuteur natif.

Puis-je utiliser ChatGPT gratuit pour la localisation ?

Oui, mais avec des risques. ChatGPT-3.5 a des erreurs fréquentes de genre, de concordance et de terminologie. Il ne gère pas bien les langues rares ou les contextes techniques. Pour des projets professionnels, privilégiez GPT-4 Turbo, Claude 3 ou Mistral 7B. Et surtout, ne jamais l’utiliser sans glossaire et sans validation humaine pour les contenus critiques.

Combien de temps faut-il pour apprendre à créer des prompts de localisation ?

Les professionnels de la localisation ont besoin de 8 à 12 semaines de formation pratique pour maîtriser les prompts efficaces. La partie la plus difficile n’est pas la technique, mais d’apprendre à penser comme une IA : structurer les instructions, anticiper les erreurs, et intégrer les contraintes culturelles dans chaque mot du prompt.

Les prompts de localisation fonctionnent-ils pour toutes les langues ?

Non. Les langues à écriture droite-gauche (arabe, hébreu, persan) et les langues à tonalité (chinois, thaï) posent encore des défis. Les modèles d’IA ont des difficultés avec les honorifiques en japonais ou les formes de politesse en coréen. Il faut des prompts spécifiques et des tests avec des locuteurs natifs pour chaque langue.

Quels outils proposent des fonctionnalités de prompt de localisation intégrées ?

Lokalise, Phrase et MemoQ intègrent désormais des fonctionnalités d’IA avec des prompts préconçus, des glossaires automatiques et des systèmes de validation (AutoLQA). Ces outils permettent de générer, tester et améliorer les prompts directement dans votre flux de travail de localisation, sans avoir à coder.

Est-ce que l’IA peut remplacer les traducteurs humains ?

Non, et elle ne devrait pas le faire. L’IA excelle à traiter les volumes, à respecter les glossaires et à générer des premières versions. Mais elle ne comprend pas les subtilités émotionnelles, les tabous culturels ou les jeux de mots. Les traducteurs humains sont indispensables pour valider, affiner et garantir que le contenu résonne vraiment avec le public cible.

6 Commentaires

Maxime Thebault

J’ai testé ça avec un client au Maroc… j’ai mis « bonjour » au lieu de « salam alaikum » dans un email. Résultat ? Il a répondu : « Vous me prenez pour un tourist ? » 😅

La localisation, c’est pas du Google Translate. C’est de l’empathie codée.

Nicolas Poizot

Il faut comprendre que l’ingénierie de prompts pour la localisation IA repose sur une architecture cognitive distribuée où le rôle du prompt n’est pas simplement directive, mais constitutif d’un cadre pragmatique d’interprétation contextuelle, intégrant des contraintes lexicales, syntaxiques, sémantiques et pragmatiques à l’échelle du token, tout en tenant compte des variations diatopiques et diastratiques des corpus cibles. Sans cette métacompétence, on obtient des traductions grammaticalement correctes mais culturellement incohérentes, ce qui génère des risques de désengagement utilisateur, voire de rejet de marque. Les études de Seatongue le confirment : une erreur de ton dans un slogan B2B peut réduire la conversion de 37 % dans les marchés arabophones, surtout si le modèle ne respecte pas les hiérarchies sociales implicites. Il faut donc penser le prompt comme un contrat linguistique et culturel, pas comme une instruction technique.

Alexis Petty-Rodriguez

Oh, donc maintenant on paye 185 $/h pour des gens qui savent écrire des phrases comme « utilisez le pronom vous et non senhor » ?

Bravo, on a créé un nouveau métier : le professeur de français pour IA.

Et moi qui croyais que « bonjour » suffisait…

On va bientôt avoir des certificats « Prompt Master Level 5 : Arabe Gulfien avec tonalité respectueuse et sans anglicismes ».

Je vais me reconvertir. J’ai déjà un CV en 12 langues… et une envie de vivre en forêt.

Myriam LAROSE

Je trouve ça profondément humain 🌍❤️

On oublie trop que les mots portent des histoires, des silences, des regards.

L’IA ne sent pas la chaleur d’un sourire en arabe, ni la gêne d’un « tu » en japonais.

Les humains, eux, savent. Et c’est ça qu’on doit protéger.

On ne traduit pas des phrases. On transmet des âmes.

Et si l’IA peut aider, tant mieux…

Mais qu’elle ne pense pas qu’elle comprend.

Elle ne fait que copier.

Nous, on ressent.

Et c’est ça qui compte.

Mohamed Maiga

En Afrique de l’Ouest, on a un truc : si tu traduis « téléphone » par « mobile » dans un contexte rural, les gens pensent que tu parles d’un objet magique.

On dit juste « téléphone » partout, même au Mali.

Les gens comprennent, même sans glossaire.

Parfois, la simplicité vaut mieux qu’un prompt de 500 mots.

Et oui, j’ai vu des gens utiliser ChatGPT-3.5 pour traduire des contrats de vente de bétail… et ça a marché.

Parce que les gens, là-bas, parlent avec leur cœur, pas avec des tokens.

Les IA, elles, parlent avec des règles.

Et parfois, les règles se trompent.

Le cœur, lui, ne ment jamais.

Camille Bonner

74 % des équipes disent que la tokenisation est la partie la plus difficile ?

Et vous croyez vraiment que c’est une question de compétence ?

Non. C’est une question de contrôle.

Les géants de la tech veulent que vous pensiez que la localisation est une science, pour vous faire payer des outils à 20 000 $/an.

En réalité, la plupart des « erreurs culturelles » sont des choix délibérés pour éviter de payer des traducteurs humains.

Et si je vous disais que le « prompt parfait » n’existe pas ?

Qu’il n’est qu’un masque pour cacher l’exploitation ?

Quand vous allez dans un pays, vous demandez à un local. Pas à une IA.

Le vrai risque ? Pas une erreur de traduction.

Une culture qui se fait voler par des algorithmes.

Et vous, vous payez pour ça.

Je vous le dis : arrêtez de croire à la magie.

Il n’y a pas de « localisation intelligente ».

Il y a juste des humains qui se font remplacer.

Et vous, vous êtes complices.