Quand un modèle linguistique comme GPT-4 ou Claude 3 est déployé en production, il ne suffit pas de le tester en laboratoire. Les données du monde réel sont trop imprévisibles, trop variées, trop dangereuses. Un modèle qui fonctionne parfaitement sur un jeu de tests peut se transformer en source de fausses informations, de réponses inappropriées ou de coûts explosifs dès qu’il rencontre des utilisateurs réels. C’est là que les tests ombre entrent en jeu. Cette méthode, devenue indispensable en 2026, permet de tester une nouvelle version d’un modèle sans jamais exposer les utilisateurs au risque.

Comment fonctionnent les tests ombre ?

Imaginez que vous devez remplacer le moteur d’un avion en plein vol. Vous ne le faites pas directement. Vous installez un nouveau moteur à côté, vous le faites tourner en parallèle, vous surveillez chaque détail - la température, la consommation de carburant, les vibrations - sans jamais couper l’ancien moteur. C’est exactement ce que font les tests ombre pour les grands modèles linguistiques (LLM).

Le système de production continue de répondre aux requêtes des utilisateurs. En parallèle, chaque requête est copiée et envoyée à une version candidate du modèle. Cette copie est appelée le modèle ombre. Il ne répond jamais aux utilisateurs. Il ne prend aucune décision. Il ne modifie rien. Il observe. Il enregistre. Il compare.

Cette architecture nécessite seulement 1 à 3 millisecondes de latence supplémentaire, selon une étude de Splunk publiée en août 2025. Les requêtes ne sont pas bloquées. Les utilisateurs ne sentent rien. Pourtant, les équipes de data science reçoivent des milliers de réponses comparatives, chaque seconde.

Quels indicateurs sont suivis ?

Les tests ombre ne se contentent pas de dire « ça marche » ou « ça ne marche pas ». Ils mesurent des choses précises, quantifiables, critiques :

- Latence de réponse : le nouveau modèle est-il plus lent ? Une augmentation de 10 ms peut coûter des milliers de dollars par jour sur une plateforme à fort trafic.

- Consommation de tokens : combien de mots le modèle utilise-t-il pour répondre ? Un modèle plus efficace peut réduire les coûts de 37 %, comme l’a montré un client AWS en septembre 2025.

- Taux d’hallucinations : combien de réponses contiennent des faits erronés ? Les outils comme SageMaker Clarify utilisent des benchmarks comme TruthfulQA pour détecter ces erreurs avec 92 % de précision.

- Violations de sécurité : le modèle génère-t-il du contenu dangereux, discriminatoire ou inapproprié ? Des classificateurs comme Perspective API identifient les réponses avec un score de sécurité supérieur à 0,7.

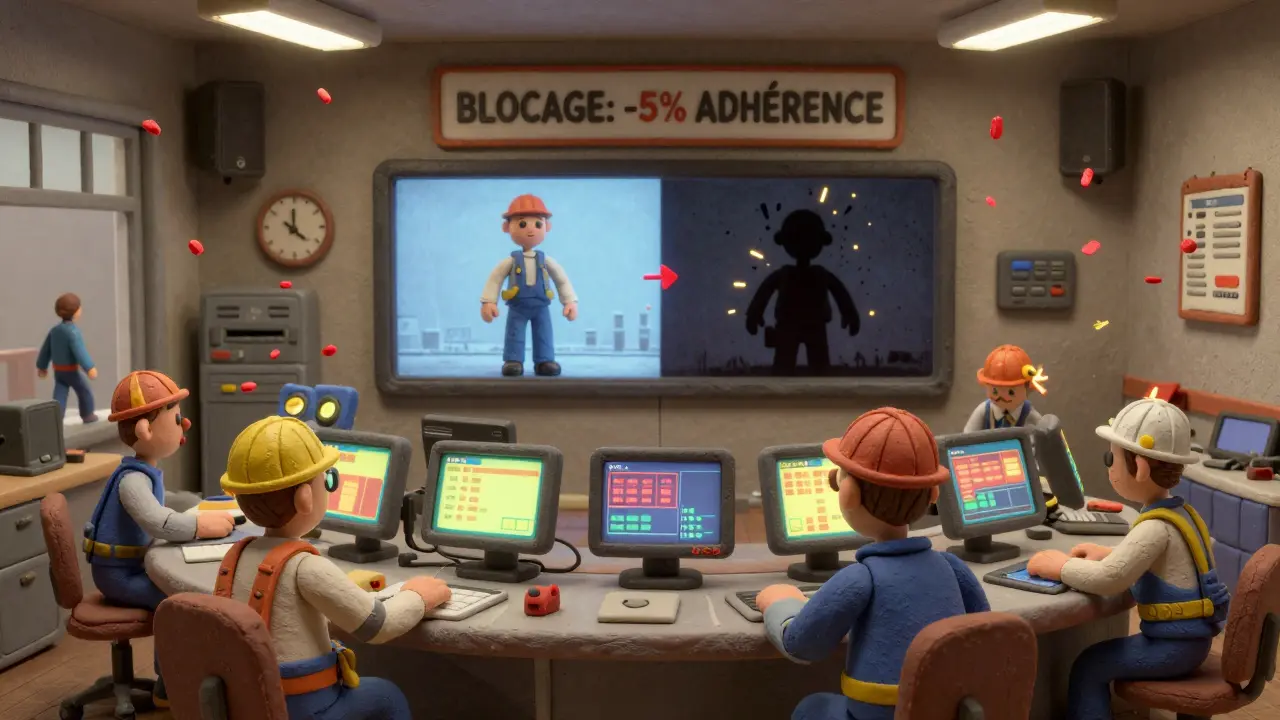

- Adhérence aux instructions : le modèle suit-il bien les consignes ? Une évaluation automatisée par un autre LLM attribue un score de 1 à 5 pour mesurer cela.

Ces métriques sont comparées à celles du modèle actuel. Si le nouveau modèle montre une baisse de 5 % sur l’adhérence aux instructions ou une augmentation de 15 % des hallucinations, le système déclenche une alerte. Pas de déploiement. Pas de risque.

Comparaison avec les tests A/B

Beaucoup confondent les tests ombre avec les tests A/B. Ce n’est pas la même chose.

Dans un test A/B, 5 à 20 % du trafic est redirigé vers le nouveau modèle. Les utilisateurs voient les deux versions. Ils cliquent, likent, détestent, réagissent. C’est utile pour mesurer l’expérience utilisateur - mais c’est risqué. Un modèle défectueux peut générer des réponses toxiques pour des centaines de personnes avant qu’on s’en rende compte.

Les tests ombre, eux, sont invisibles. Ils ne touchent personne. Ils sont conçus pour la première validation : est-ce que ce modèle est sûr à déployer ? Gartner l’a classé en novembre 2025 comme la méthode #1 pour cette étape, avec un score de 4,7/5 en sécurité. Les tests A/B, eux, arrivent après, pour la dernière étape : est-ce que les utilisateurs aiment cette version ? Ils ont un score de 4,9/5 pour l’expérience utilisateur.

Le problème ? Les tests ombre ne captent pas les signaux humains. Une étude de Wandb en septembre 2025 a montré que 63 % des régressions graves détectées par A/B testing étaient passées inaperçues en test ombre. Parce que les utilisateurs ne réagissent pas. Ils ne disent pas : « Cette réponse est bizarre. » Ils ne cliquent pas sur « Je n’aime pas ». Ils ne se plaignent pas. Ils partent.

Qui utilise les tests ombre ? Et pourquoi ?

En 2025, 78 % des entreprises du Fortune 500 utilisent les tests ombre. Dans les secteurs à haut risque, c’est presque universel :

- Services financiers : 89 % d’adoption. Une erreur de prédiction peut coûter des millions.

- Santé : 76 %. Un modèle qui hallucine sur un diagnostic peut être fatal.

- Commerce en ligne : 63 %. Une réponse inappropriée peut nuire à la réputation.

La pression réglementaire a accéléré l’adoption. Le Règlement européen sur l’IA, entré en vigueur en juin 2025, exige des méthodes d’évaluation complètes avant déploiement. Les tests ombre répondent directement à cette exigence.

Un ingénieur ML chez une plateforme e-commerce a partagé sur Reddit en octobre 2025 : « Le test ombre a détecté une augmentation de 23 % des réponses nuisibles quand on a essayé de passer à un modèle open-source plus récent. Les tests en laboratoire l’avaient complètement raté. »

Un autre, dans une startup de santé, a déclaré : « Ça a pris trois semaines pour configurer les métriques de comparaison. On a perdu du temps. »

Le vrai défi ? Pas la technologie. Le vrai défi, c’est la surcharge d’alertes. Des équipes reçoivent des centaines de notifications par jour. Sans seuils clairs, sans automatisation, on finit par ignorer tout. C’est ce qu’appelle l’« alerte fatigue ». Une étude de Splunk en janvier 2026 a montré que les équipes qui automatisaient les seuils de détection réduisaient les incidents de production de 68 %.

Comment mettre en place les tests ombre ?

Voici ce qu’il faut faire pour réussir :

- Utilisez une plateforme compatible : AWS SageMaker Clarify, Google Vertex AI ou CodeAnt AI sont les plus matures en 2026. Ils gèrent déjà la duplication du trafic et les métriques clés.

- Testez pendant au moins un cycle complet : 7 à 14 jours. Pas 2 jours. Les modèles réagissent différemment selon les heures, les jours, les types d’utilisateurs.

- Définissez des seuils automatisés : si le nouveau modèle a une performance inférieure à 95 % du modèle actuel sur l’une des métriques clés, bloquez le déploiement.

- Intégrez-le à votre pipeline CI/CD : le test ombre ne doit pas être une étape manuelle. Il doit être déclenché automatiquement à chaque nouvelle version du modèle.

- Surveillez les coûts : doubler l’infrastructure augmente les frais cloud de 15 à 25 %. Prévoyez un budget pour cette période.

Il faut environ 2 à 4 semaines à une équipe ML pour configurer un pipeline solide, selon Algomox. Les compétences requises ? De l’ingénierie des infrastructures (pour dupliquer le trafic), de la conception de métriques d’évaluation, et de l’analyse statistique pour savoir si une différence est réelle ou juste du bruit.

Les limites et les dangers

Les tests ombre ne sont pas une solution magique. Dr. Sarah Chen du MIT a mis en garde en décembre 2025 : « Les attaques de poisonnement de données, conçues pour rester invisibles tout en préservant la performance globale, échappent aux tests ombre. »

Autrement dit : un modèle peut sembler parfait en test ombre - mais être corrompu par des données malveillantes dans son entraînement. Il faut des systèmes de détection supplémentaires pour ça.

Et puis, il y a le coût. Les entreprises qui ne font pas de tests ombre paient cher. McKinsey estime qu’une régression non détectée coûte en moyenne 1,2 million de dollars par incident - en pertes de revenus, en réputation, en remédiations. Les tests ombre, avec leur surcoût de 20 %, deviennent rapidement un investissement rentable.

Le futur des tests ombre

En janvier 2026, FutureAGI a lancé des tableaux de bord en temps réel qui relient les métriques de test ombre aux KPI métier : « Si le nouveau modèle réduit les hallucinations de 10 %, combien de réclamations clients cela évite-t-il ? »

CodeAnt AI a ajouté des calculs automatiques de significativité statistique pour réduire les faux positifs. Et AWS a amélioré la détection des hallucinations à 92 % de précision.

Gartner prédit qu’en 2027, 75 % des entreprises auront rendu les tests ombre obligatoires dans leurs protocoles de validation. Ce n’est plus une option. C’est une norme de sécurité.

Le modèle linguistique n’est plus un outil de recherche. Il est un acteur de production. Et comme tout acteur de production, il doit être testé avant chaque scène. Sans risque. Sans impact. Sans surprises.

Quelle est la différence entre les tests ombre et les tests A/B pour les LLM ?

Les tests ombre copient tout le trafic vers un modèle candidat sans jamais le montrer aux utilisateurs. Ils servent à valider la sécurité et la performance technique. Les tests A/B envoient une partie du trafic (5-20 %) au nouveau modèle, et les utilisateurs voient les deux versions. Ils mesurent l’expérience réelle, comme les clics ou les commentaires. Les tests ombre sont pour la première étape (est-ce que c’est sûr ?), les A/B pour la dernière (est-ce que les gens aiment ?).

Les tests ombre peuvent-ils détecter les hallucinations ?

Oui, c’est l’un de leurs principaux avantages. Des outils comme SageMaker Clarify utilisent des benchmarks comme TruthfulQA pour analyser les réponses du modèle ombre et détecter les faits erronés avec une précision de 92 %. Ils comparent chaque réponse avec des sources fiables pour identifier les hallucinations.

Est-ce que les tests ombre coûtent cher ?

Oui, mais c’est un coût maîtrisé. Doubler l’infrastructure pour le modèle ombre augmente les frais cloud de 15 à 25 % pendant la période de test. Mais cela évite des pertes de 1,2 million de dollars en moyenne par incident non détecté. Pour les entreprises à haut risque, c’est un investissement très rentable.

Pourquoi les tests ombre ne détectent-ils pas tous les problèmes ?

Parce qu’ils ne mesurent pas l’expérience humaine. Ils ne voient pas les utilisateurs réagir, se frustrer ou abandonner. Une réponse peut être techniquement correcte mais maladroite, ou trop formelle. Ce type de problème, souvent lié à la tonalité ou au ton, est détecté par les tests A/B, pas par les tests ombre.

Faut-il utiliser les tests ombre pour tous les modèles ?

Pas pour tous. Pour un petit modèle interne qui ne touche que 10 utilisateurs, ce n’est pas nécessaire. Mais pour tout modèle utilisé par des milliers de clients, en production, dans des secteurs comme la finance, la santé ou les services publics - oui, c’est obligatoire. La réglementation l’exige, et le risque est trop élevé pour ne pas le faire.