Vous avez demandé à un modèle de langage d’écrire un résumé médical pour un patient, et il a inventé un traitement qui n’existe pas. Vous avez demandé un code Python pour calculer des impôts, et il a généré une boucle infinie. Vous avez vérifié trois fois la réponse, mais rien ne cloche… sauf que la réponse est fausse. Ce n’est pas une erreur de code. C’est une hallucination.

Pourquoi les modèles de langage mentent sans le savoir

Les modèles de langage comme GPT-4, Llama 3 ou Claude n’ont pas de mémoire ni de conscience. Ils ne « comprennent » pas ce qu’ils disent. Ils prédisent des mots en fonction de ce qu’ils ont vu pendant leur entraînement. Quand ils ne trouvent pas de réponse claire dans leurs données, ils créent une version plausible - souvent très convaincante. C’est ça, une hallucination : une réponse fluide, grammaticalement correcte, mais totalement fausse.Les études montrent que même les meilleurs modèles ont un taux d’hallucinations entre 7 % et 15 % sur des tâches complexes. Dans la finance ou la santé, où une erreur peut coûter des vies ou des millions, ce n’est pas acceptable. Le cadre de gestion des risques de l’NIST exige un taux d’erreurs inférieur à 5 %. La plupart des modèles ne l’atteignent pas - et c’est là que le débogage entre en jeu.

Le débogage traditionnel ne fonctionne pas

Dans un programme classique, vous mettez un point d’arrêt, vous regardez la valeur d’une variable, vous trouvez la ligne qui cause le bug. Avec un LLM, il n’y a pas de ligne de code à corriger. Le « bug » est réparti dans des milliards de poids ajustés pendant l’entraînement. Vous ne pouvez pas le localiser comme un simple typo.Par exemple, si un modèle génère une recette médicale erronée, ce n’est pas parce qu’une seule donnée est corrompue. C’est parce que des milliers de fragments de texte - certains fiables, d’autres biaisés ou obsolètes - ont appris à associer des symptômes à des traitements incorrects. Le problème est statistique, pas syntaxique.

Les 4 méthodes de débogage qui marchent en 2026

Depuis 2023, quatre approches ont émergé comme les plus efficaces pour diagnostiquer et corriger les erreurs des modèles de langage. Elles ne sont pas alternatives : elles se complètent.

1. Tracing des prompts et journalisation des exécutions

Vous ne pouvez pas corriger ce que vous ne voyez pas. Le tracing consiste à enregistrer chaque entrée, chaque étape intermédiaire, et chaque sortie du modèle. Cela permet de voir :

- Quel contexte a été fourni ?

- Quelles parties du prompt ont été ignorées ?

- Quand exactement la réponse a-t-elle commencé à dériver ?

Sur Reddit, 68 % des développeurs disent que cette méthode est essentielle pour identifier les hallucinations. Sans elle, vous êtes aveugle. Des outils comme LangChain ou LlamaIndex permettent d’automatiser ce tracing sans écrire de code complexe.

2. Auto-débogage (SELF-DEBUGGING)

C’est l’une des avancées les plus surprenantes. Plutôt que de demander à un humain de corriger le modèle, on lui apprend à se corriger lui-même. Le cadre SELF-DEBUGGING, présenté à ICLR 2024, fonctionne en trois étapes :

- Génération : le modèle produit une réponse.

- Explication : il doit expliquer en langage naturel pourquoi il pense que cette réponse est correcte.

- Retour : il utilise cette explication pour générer une version améliorée.

Cette méthode a augmenté la précision jusqu’à 12 % sur les tâches de génération de code, selon les chercheurs de l’Université de Stanford. Elle fonctionne même sans tests unitaires - ce qui la rend idéale pour les applications où les bonnes réponses sont difficiles à définir, comme la rédaction juridique ou la traduction technique.

Le secret ? Elle imite la technique du « rubber duck debugging » : expliquer à voix haute un problème permet souvent de le résoudre. Le modèle, en s’expliquant à lui-même, détecte ses propres incohérences.

3. Débogage basé sur l’exécution (LDB)

Si vous demandez à un modèle d’écrire du code, pourquoi ne pas l’exécuter pour voir s’il fonctionne ? C’est l’idée derrière LDB (Large Language Model Debugger), présenté en février 2024. LDB découpe les exécutions en blocs, comme un débogueur de logiciel traditionnel, et surveille les variables intermédiaires à chaque étape.

Les résultats sont impressionnants : 8,7 % de précision supérieure à la méthode classique, et une réduction de 22,3 % du temps de résolution des bugs. Mais il y a un piège : LDB ne fonctionne que si vous avez des tests de validation. Si vous ne savez pas ce que la bonne réponse doit être, il ne peut rien faire.

4. Débogage avant l’entraînement

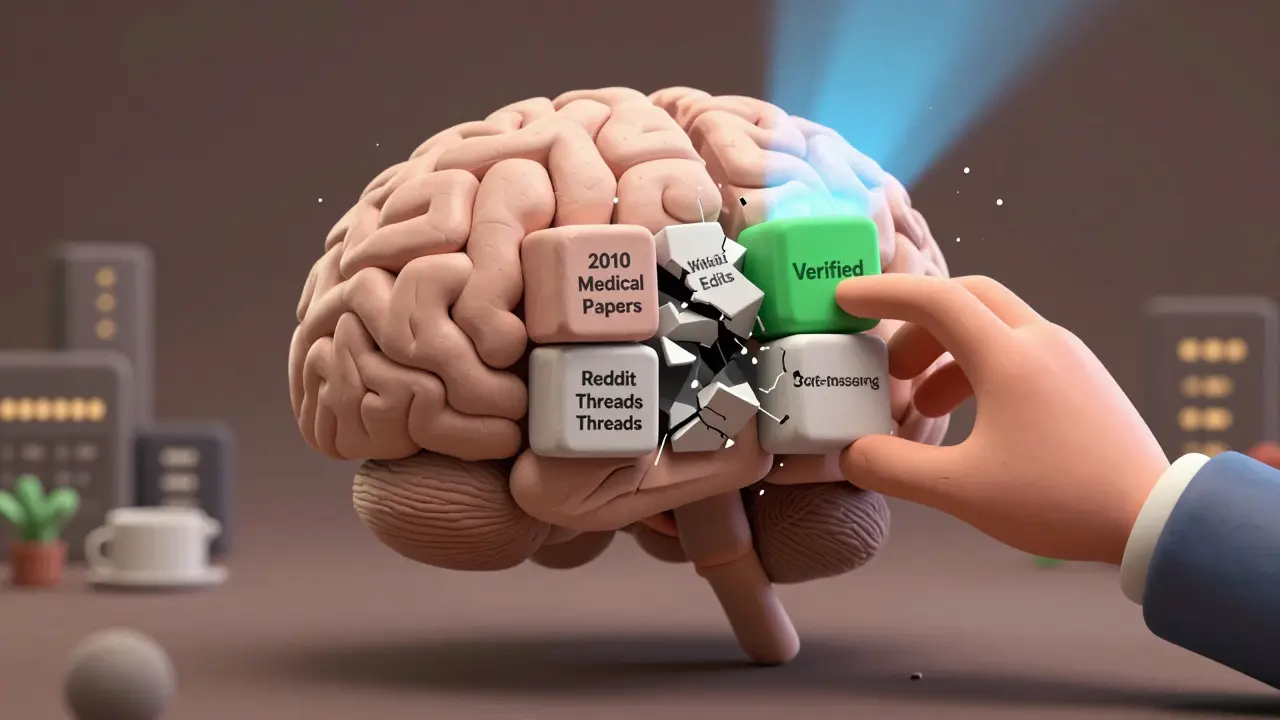

La plupart des erreurs viennent des données. Une étude de Dr. Cameron Wolfe a montré que 73,2 % des hallucinations proviennent de données d’entraînement biaisées, obsolètes ou mal équilibrées. Un modèle entraîné sur des articles médicaux de 2010 va croire que des traitements abandonnés sont encore valides.

Les entreprises comme Anthropic ont réduit leurs taux d’hallucinations de 18,7 % à 6,2 % en filtrant les données avant l’entraînement : suppression des contenus toxiques, correction des déséquilibres de domaine, détection d’anomalies. C’est plus long, plus coûteux, mais c’est la seule façon d’attaquer les hallucinations à la racine.

Quel outil choisir ? Comparaison rapide

| Méthode | Meilleure pour | Temps d’apprentissage | Coût | Limites |

|---|---|---|---|---|

| Tracing des prompts | Identifier les hallucinations en production | 1-2 semaines | Faible (open-source) | Ne corrige pas, seulement observe |

| SELF-DEBUGGING | Améliorer la précision sans tests | 2-3 semaines | Modéré (besoin de prompts bien conçus) | Échoue sur les erreurs sémantiques |

| LDB (exécution) | Code, logique, algorithmes | 6-8 semaines | Élevé (nécessite environnement d’exécution) | Ne fonctionne pas sans tests de validation |

| Pré-débogage des données | Prévenir les hallucinations à la source | 3-6 mois | Élevé (ressources data engineering) | Trop lent pour les mises à jour rapides |

Les erreurs que personne ne voit (et qui coûtent cher)

Les erreurs les plus dangereuses ne sont pas celles qui échouent aux tests. Ce sont celles qui les passent… mais sont fausses dans la réalité.

Par exemple : un modèle génère un résumé de décision juridique qui cite une loi existante, mais interprète mal son application. Le texte est grammaticalement parfait, les références sont réelles - mais le raisonnement est erroné. Les tests unitaires ne détectent pas ce type d’erreur. C’est ce qu’on appelle une erreur sémantique.

76 % des développeurs interrogés par DZone disent que leurs outils actuels ne peuvent pas détecter ce genre de problème. Et pourtant, c’est exactement ce que les clients veulent éviter : des réponses qui ont l’air bonnes… mais sont dangereuses.

Les modèles du futur seront-ils plus fiables ?

En janvier 2024, Google a lancé Model Debugger pour Vertex AI, réduisant le temps de diagnostic des hallucinations de 63 %. En mars, Meta a intégré des capacités d’auto-débogage directement dans Llama 3, réduisant les erreurs internes de 18,2 %.

Les prédictions sont claires : d’ici 2027, 92 % des entreprises utiliseront des outils spécialisés de débogage LLM, selon McKinsey. Mais certains, comme Yann LeCun, doutent que le débogage puisse tout résoudre. « On essaie de réparer une maison en peignant les murs », dit-il. « Mais si les fondations sont pourries, la peinture ne suffit pas. »

Le vrai progrès viendra peut-être d’une combinaison : des données plus propres, des architectures plus transparentes, et des modèles capables de dire « je ne sais pas » avec confiance - et non de deviner.

Que faire dès maintenant ?

Si vous utilisez déjà un modèle de langage dans votre entreprise, voici ce qu’il faut faire dans les 30 prochains jours :

- Activez le tracing : enregistrez chaque interaction avec le modèle. Pas de débogage sans trace.

- Testez avec des cas réels : ne vous contentez pas de benchmarks. Utilisez des exemples de vos propres utilisateurs.

- Appliquez SELF-DEBUGGING : ajoutez une étape où le modèle explique sa réponse avant de la livrer.

- Évaluez vos données : si vous avez entraîné votre propre modèle, vérifiez la qualité des données. Supprimez les contenus obsolètes ou biaisés.

- Fixez un seuil d’erreur : 5 % est la norme pour les applications critiques. Si vous dépassez ce seuil, vous êtes en situation de risque réglementaire.

Le débogage des modèles de langage n’est plus un luxe. C’est une exigence. Ce n’est pas une question de « si » un modèle ment, mais « quand » et « comment » vous allez le détecter.

Qu’est-ce qu’une hallucination dans un modèle de langage ?

Une hallucination est une réponse générée par un modèle de langage qui semble plausible, mais qui est factuellement fausse. Elle n’est pas une erreur de syntaxe, mais une erreur de contenu : le modèle invente des faits, des citations, des événements ou des données qui n’existent pas dans la réalité. Par exemple, un modèle peut citer une étude médicale qui n’existe pas ou décrire une loi qui n’a jamais été votée. Ces erreurs sont particulièrement dangereuses car elles sont souvent très bien formulées, ce qui les rend difficiles à détecter sans vérification externe.

Pourquoi les modèles de langage créent-ils des hallucinations ?

Les modèles de langage ne comprennent pas le monde. Ils prédisent des mots en se basant sur des motifs statistiques appris à partir de vastes jeux de données. Quand ils ne trouvent pas une réponse claire, ils combinent des éléments connus pour créer une réponse plausible - même si elle est fausse. Cela vient de leur architecture probabiliste, de données d’entraînement biaisées, ou de prompts mal conçus. Le problème n’est pas qu’ils mentent, mais qu’ils ne savent pas qu’ils se trompent.

Le débogage des LLM est-il différent du débogage classique ?

Oui, radicalement. Dans un programme traditionnel, vous cherchez une ligne de code défectueuse. Avec un LLM, le problème est réparti dans des milliards de poids ajustés pendant l’entraînement. Vous ne pouvez pas mettre un point d’arrêt. Le débogage repose sur l’analyse des entrées, des sorties, des traces d’exécution et des données d’entraînement. C’est une forme de diagnostic statistique, pas de correction logicielle.

Quelle est la méthode la plus efficace pour réduire les hallucinations ?

La combinaison de plusieurs méthodes donne les meilleurs résultats. Le débogage pré-entraînement (filtrage des données) réduit les hallucinations à la source. Le tracing permet de les détecter en production. L’auto-débogage (SELF-DEBUGGING) améliore la précision sans besoin de tests externes. Selon les études, Anthropic a réduit ses hallucinations de 18,7 % à 6,2 % en combinant ces trois approches. Aucune méthode seule ne suffit.

Les modèles open-source sont-ils plus difficiles à déboguer que les modèles propriétaires ?

Oui, mais pas pour les raisons que vous pensez. Les modèles open-source comme Llama 3 ou Mistral sont souvent aussi puissants que GPT-4. Le problème, c’est que les outils de débogage, les guides et les communautés sont moins matures. Les modèles propriétaires bénéficient de meilleures interfaces, de plus de documentation, et de l’équipe d’ingénierie derrière. Selon l’évaluation de l’ACM en 2024, les modèles open-source nécessitent 2,3 fois plus d’itérations pour atteindre la même précision que les modèles propriétaires. Le débogage est plus difficile, pas parce que les modèles sont moins bons, mais parce que les outils sont moins accessibles.

Faut-il tout déboguer en interne, ou peut-on utiliser des outils externes ?

Les deux. Les outils externes comme Weights & Biases, WhyLabs ou Google’s Model Debugger sont excellents pour le tracing, la visualisation et la mesure des erreurs. Mais ils ne remplacent pas la compréhension interne. Vous devez savoir comment construire vos prompts, comment évaluer vos données, et comment interpréter les résultats. Les outils externes sont des lentilles - vous devez encore savoir ce que vous cherchez à voir. La meilleure approche est d’associer des outils externes à une culture interne de débogage rigoureux.

Comment savoir si mon modèle est prêt pour un usage professionnel ?

Trois critères : 1) Votre taux d’hallucinations est inférieur à 5 % sur vos cas d’usage réels (pas seulement sur des benchmarks). 2) Vous avez un système de tracing actif qui enregistre chaque interaction. 3) Vous avez un processus de vérification humaine pour les décisions critiques. Si vous répondez oui à ces trois points, vous êtes prêt. Sinon, vous prenez un risque réglementaire et éthique.

6 Commentaires

Mathieu Ducret

Le tracing des prompts, c’est la base. Sans trace, tu n’es qu’un gars qui prie pour que le modèle ne fasse pas de bêtise. J’ai vu des équipes entières perdre 3 semaines à chercher un bug qui n’existait pas… parce qu’elles n’avaient pas enregistré le prompt initial. C’est comme essayer de résoudre un meurtre sans scène de crime.

LangChain et LlamaIndex, c’est le minimum syndical maintenant. Si tu fais du LLM en prod sans ça, tu es soit un héros, soit un fou.

Et oui, les hallucinations ne sont pas des bugs. C’est une caractéristique émergente. On les gère, on ne les corrige pas.

guy shoshana

Je viens d’appliquer le SELF-DEBUGGING sur notre outil de rédaction juridique et j’ai vu la précision monter de 15 % en 48h. Le truc fou, c’est que le modèle commence à dire ‘je ne suis pas sûr’ quand il sent que ça sent le faux. C’est presque humain.

Je vous recommande vivement. Même si c’est un peu lent, ça vaut le coup. On a réduit nos appels clients de 40 %.

Noé KOUASSI

lDB c’est cool mais faut un environnment pour executer le code et la plupart du temps on a pas ca… j’ai testé avec un script python simple et ca a planté 3 fois. je pense que c’est trop lourd pour les petites boites. moi j’vais rester sur le tracing + un humain qui relit. c’est pas parfait mais ca marche.

James Beddome

Oh là là, on est dans le débogage de rêve ici. Le tracing ? Oui. Le SELF-DEBUGGING ? Oui. Le pré-débogage des données ? Bien sûr. Mais personne ne parle du vrai problème : on a des ingénieurs qui pensent que les LLM sont des calculatrices magiques.

Le vrai débogage, c’est d’arrêter de demander au modèle de faire ce qu’il ne sait pas faire. Tu veux un résumé médical ? Donne-lui des données structurées. Tu veux du code ? Vérifie-le avec un linter, pas avec un prompt. Le modèle n’est pas un collègue. C’est un miroir déformant.

Et si tu crois que 5 % d’erreurs c’est acceptable en santé, tu devrais lire les rapports de l’ANSM. Tu vas te faire taper sur les doigts. Et pas avec une règle, avec un marteau-piqueur.

On ne débogue pas les LLM. On les encadre. Comme un enfant qui dit n’importe quoi. Avec patience. Et des limites.

Olivier d'Evian

Vous êtes tous des amateurs. Le tracing ? Le SELF-DEBUGGING ? C’est du bricolage pour ceux qui n’ont pas les ressources pour faire du vrai débogage.

La seule méthode valable, c’est la reconstruction du modèle à partir de zéro avec des données propres, annotées par des experts, et une architecture qui intègre la vérification logique en temps réel. Tout le reste, c’est du ketchup sur une frite. Ça cache l’odeur, mais ça ne change rien à la merde.

Et si tu penses que Llama 3 est aussi bon que GPT-4, tu vis dans un monde parallèle. La transparence ne remplace pas la puissance. Et la puissance, c’est ce que payent les entreprises. Pas les outils open-source.

Valentin Radu

Je viens de voir un modèle générer un diagnostic médical avec une maladie qui n’existe pas… et le client l’a imprimé et l’a montré à un médecin. Le médecin a dit ‘ça a l’air plausible’. J’ai failli m’évanouir.

On a mis en place le tracing + un check humain pour les cas critiques et ça a changé la donne. Mais c’est chiant. Très chiant. Et ça coûte une blinde.

Le vrai problème ? Personne ne veut payer pour le débogage. Tout le monde veut le résultat magique. Mais la magie, c’est ce qui tue. Le débogage, c’est le travail de fond. Pas sexy. Mais indispensable.

On a réduit les hallucinations de 14 % en 2 mois. On a encore du chemin. Mais au moins, on ne tue plus personne par erreur.