Vous avez déjà eu ce sentiment : votre invite pour un modèle linguistique comme GPT-4 fait 5 000 jetons, et vous savez qu’elle pourrait être bien plus courte. Mais si vous la raccourcissez, vous risquez de perdre quelque chose d’essentiel. Ce n’est pas une simple question de propreté - c’est une question de coût, de vitesse, et de fiabilité. La compression des invites est la solution concrète qui permet de réduire jusqu’à 80 % des jetons sans sacrifier la qualité des réponses. Et oui, ça fait économiser des milliers de dollars par mois.

Comment ça marche, concrètement ?

Imaginez que vous envoyez à un modèle une longue liste de documents, des instructions détaillées, des exemples, et des rappels de contexte. La plupart de ces éléments sont inutiles. Un modèle comme GPT-4 n’a pas besoin de tout lire. Il a besoin de ce qui compte. La compression des invites, c’est un processus automatisé qui identifie et supprime les parties redondantes, peu informatives ou hors sujet - tout en gardant les éléments qui font la différence dans la réponse finale.

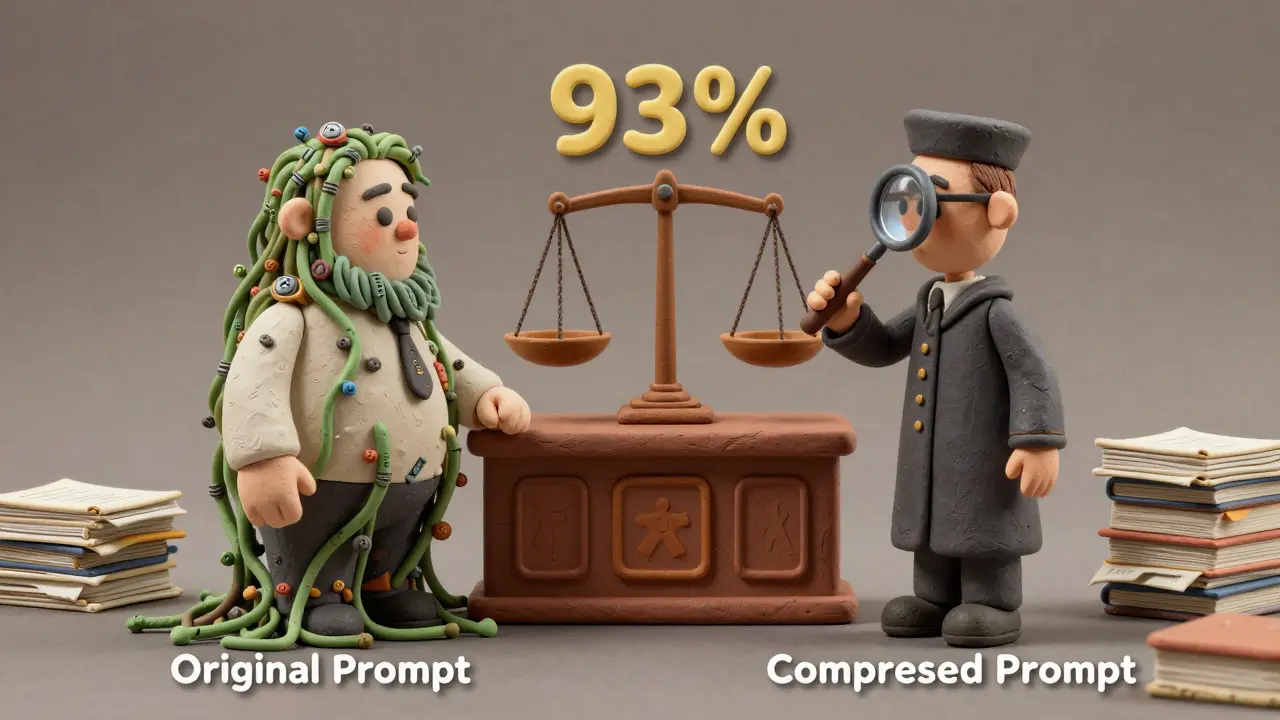

Ce n’est pas une simple suppression de texte. C’est une intelligence artificielle qui analyse votre invite, évalue l’importance de chaque mot, et décide ce qui peut être enlevé. Microsoft a développé LLMLingua, un outil qui utilise un petit modèle (comme LLaMA-7B) pour faire ce travail. Il ne s’agit pas de résumer comme un humain - il s’agit de réécrire pour que le modèle lui-même comprenne mieux. Et le résultat ? Des invites de 5 000 jetons réduites à 250, avec une précision de 93 % sur des tâches complexes comme la résolution de problèmes mathématiques ou la réponse à des questions basées sur des documents.

Deux approches principales : dures et douces

Il existe deux façons de compresser une invite. La première, appelée hard prompt compression, consiste à supprimer des jetons. C’est comme couper les branches mortes d’un arbre : vous enlevez ce qui ne sert à rien. LLMLingua fait ça en identifiant les phrases répétitives, les exemples redondants, ou les instructions trop longues. Par exemple, au lieu d’écrire « Expliquez-moi comment fonctionne un moteur à combustion interne en 3 paragraphes, en utilisant des termes simples, comme si vous parliez à un étudiant de 15 ans », vous pouvez dire : « Résumez le moteur à combustion pour un ado. »

La deuxième approche, soft prompt compression, est plus subtile. Elle ne supprime pas de mots - elle les transforme. Elle convertit votre texte en vecteurs numériques dans un espace latent. Ces vecteurs, appelés « jetons compressés », sont plus petits, plus efficaces, et peuvent être réutilisés entre différents modèles. C’est comme enregistrer une recette sous forme de code plutôt que d’un livre de cuisine. Le modèle n’a plus besoin de lire les mots - il reconnaît directement la structure.

Quand ça marche vraiment bien

La compression des invites est un coup de génie pour les systèmes de type RAG (Retrieval-Augmented Generation). Dans ces cas-là, vous récupérez plusieurs documents pertinents à partir d’une base de données, et vous les envoyez tous au modèle pour qu’il réponde à une question. Mais ces documents peuvent faire 10 000 jetons ensemble. Sans compression, vous dépassez la limite du modèle. Avec compression, vous pouvez intégrer 4 ou 5 documents au lieu de 1, tout en restant dans les limites.

Les entreprises qui utilisent des chatbots pour le service client en tirent un énorme avantage. Un cas réel chez Sandgarden a montré qu’après compression, les coûts mensuels sur GPT-4 sont tombés de 28 000 $ à 9 650 $ - une économie de 65 % - sans que les clients ne remarquent la moindre différence dans la qualité des réponses. Sur des milliers de requêtes par jour, ça fait une énorme différence.

Les tâches de raisonnement, comme résoudre des problèmes mathématiques (GSM8K) ou des énigmes logiques (BBH), bénéficient aussi énormément. Les tests de Microsoft montrent que même à 15x de compression, la précision reste à plus de 90 %. C’est parce que ces tâches dépendent de la structure logique, pas du vocabulaire exact.

Les pièges à éviter

La compression n’est pas magique. Si vous poussez trop loin, vous perdez des nuances. Dans un cas d’étude sur des diagnostics médicaux, une compression de 15x a fait augmenter les hallucinations de 8 % à 22 %. Pourquoi ? Parce que des mots comme « légèrement », « probablement », ou « dans certains cas » ont été supprimés - et ces mots sont cruciaux en médecine.

Les tâches créatives aussi souffrent. Si vous demandez à un modèle d’écrire un poème, un discours ou un script, une trop grande compression peut le rendre mécanique, sans âme. Il faut garder un peu de fluidité. La règle simple : pour les tâches analytiques, vous pouvez compresser jusqu’à 20x. Pour les tâches créatives, restez sous 5x.

Et attention à la calibration. Un outil qui fonctionne pour les questions de service client ne marchera pas pour les contrats juridiques. Il faut tester, mesurer, et ajuster. Les équipes qui réussissent le mieux utilisent des métriques spécifiques à leur domaine : précision, taux d’hallucinations, temps de réponse, et satisfaction utilisateur.

Combien ça coûte ? Et combien ça économise ?

OpenAI facture 10 $ pour un million de jetons d’entrée avec GPT-4-turbo. Si votre application utilise 1 million de jetons par jour, vous dépensez 300 $ par mois. Avec une compression de 70 %, vous passez à 300 000 jetons - soit 9 $ par mois. C’est une économie de 291 $.

Et ce n’est pas seulement l’argent. Moins de jetons = moins de temps de traitement = réponses plus rapides. Microsoft a mesuré une réduction de latence de 57,9 %. Pour un chatbot qui répond à des milliers d’utilisateurs en même temps, chaque milliseconde compte. Les utilisateurs ne voient pas la compression - mais ils sentent la rapidité.

Comment commencer ?

Vous n’avez pas besoin d’être un expert en IA pour essayer. Voici comment faire en 4 étapes :

- Identifiez votre invite la plus utilisée. Celle qui fait le plus de jetons.

- Utilisez LLMLingua (disponible sur GitHub) pour la compresser. Il suffit de quelques lignes de code Python.

- Comparez les réponses avant et après. Testez sur 50 exemples réels de votre domaine.

- Fixez un seuil : si la précision tombe en dessous de 90 %, diminuez la compression.

Les développeurs expérimentés mettent 2 à 3 semaines pour intégrer la compression dans leur pipeline. Les entreprises avec des équipes dédiées mettent 3 à 5 semaines pour le déployer à grande échelle. Le plus gros défi ? Apprendre à ne pas avoir peur de supprimer. Beaucoup pensent que plus d’information = meilleure réponse. C’est faux. Plus d’information = plus de bruit.

L’avenir : plus que de la compression

La compression des invites est juste le début. Les chercheurs travaillent déjà sur des systèmes qui ne compressent pas - mais priorisent. Plutôt que d’enlever des mots, ils apprennent à donner plus de poids aux parties les plus importantes. C’est comme mettre un projecteur sur les mots clés, et éteindre le reste.

À l’horizon 2027, Gartner prédit que 85 % des applications d’IA en entreprise intégreront ce type d’optimisation. Ce n’est plus une option. C’est une nécessité. Les modèles deviennent plus gros, les contextes plus longs, et les coûts plus élevés. Celui qui maîtrise la compression des invites, maîtrise le futur de l’ingénierie des prompts.

Que faire si ça ne marche pas ?

Si votre invite compressée donne des réponses étranges ou inexactes, voici ce qu’il faut vérifier :

- La compression est-elle trop agressive ? Essayez avec un ratio de 5x au lieu de 15x.

- Le modèle cible est-il adapté ? Certains modèles (comme Claude) réagissent mieux à la compression que d’autres.

- Avez-vous testé sur vos propres données ? Ce qui marche sur un jeu de données public ne marche pas forcément sur vos documents internes.

- Les instructions de base sont-elles encore claires ? Parfois, la compression supprime la première phrase qui dit « Réponds en français ».

Si vous êtes bloqué, commencez par un seul type d’invite. Un chatbot de service client, par exemple. Faites un test A/B : 500 requêtes avec l’invite originale, 500 avec la version compressée. Comparez les taux de satisfaction. Si les deux sont égaux, vous avez gagné. Si non, ajustez.

La compression des invites réduit-elle la qualité des réponses ?

Pas systématiquement. À des ratios modérés (5x à 15x), la qualité reste stable sur les tâches analytiques comme la résolution de problèmes ou la réponse à des questions basées sur des documents. Mais pour les tâches créatives ou critiques (comme la médecine ou le droit), une compression excessive peut entraîner des hallucinations ou des pertes de nuances. Il faut toujours tester avec vos propres données.

Quel outil gratuit puis-je utiliser pour commencer ?

LLMLingua, développé par Microsoft, est le plus accessible. Il est open-source, disponible sur GitHub, et fonctionne avec des modèles comme GPT-4, LLaMA, ou Claude. Il suffit d’installer la bibliothèque Python et d’ajouter 3 lignes de code à votre pipeline d’invite.

La compression fonctionne-t-elle avec tous les modèles ?

Oui, mais avec des résultats variables. Elle fonctionne très bien avec GPT-4, Claude 3, et LLaMA 3. Certains modèles plus petits ou moins entraînés sur des tâches de compréhension contextuelle réagissent moins bien. Il est recommandé de tester sur votre modèle cible avant de déployer en production.

Combien de temps faut-il pour intégrer la compression dans un système existant ?

Pour un développeur expérimenté, l’intégration d’un seul type d’invite prend entre 1 et 3 jours. Pour un déploiement complet dans une entreprise (plusieurs pipelines, plusieurs modèles, plusieurs langues), comptez 3 à 5 semaines, y compris les tests et l’ajustement des seuils.

La compression des invites est-elle une tendance passagère ?

Non. Avec les prix des jetons qui restent élevés et les contextes qui ne cessent de grandir, la compression devient une couche standard dans les pipelines d’IA. Gartner prédit qu’en 2027, 85 % des applications d’IA en entreprise l’auront intégrée. Ce n’est pas une fonctionnalité - c’est une nécessité opérationnelle.

8 Commentaires

Gerard Paapst

J’ai testé LLMLingua sur mon chatbot client, et là je peux dire que c’est une révolution. On est passé de 12k jetons à 1k, et les réponses sont même plus claires. Les clients pensent qu’on a amélioré le bot, mais en fait on a juste supprimé du bruit. Merci pour ce partage ! 😊

Njienou Joyce

Franchement c’est n’importe quoi. Si tu compresses trop, le modèle devient stupide. J’ai vu un truc comme ça à Yaoundé, un chatbot qui répondait ‘ok’ à tout. C’est pas de l’IA, c’est de la paresse.

Le ninja fortnite du 96

Brooo… la compression c’est juste la preuve que les gens ont peur de penser. On veut des réponses rapides mais on oublie que la profondeur, c’est pas un bug, c’est une caractéristique 😎 L’IA doit pas être un robot de service client, c’est un esprit qui dialogue. Et si tu compresses tout, tu tues l’âme du langage. #DeepThoughts #AIisNotATool

Georges ASSOBA

Je dois souligner, avec une précision rigoureuse, que la notion de ‘compression douce’ est mal définie dans cet article : il s’agit, en réalité, d’une forme de représentation vectorielle latent, et non d’une ‘transformation’ des mots - ce qui est une erreur conceptuelle majeure, car les mots ne sont pas ‘transformés’, ils sont encodés dans un espace de caractéristiques, ce qui implique une perte d’interprétabilité, et non une amélioration syntaxique. De plus, l’affirmation selon laquelle ‘les jetons compressés peuvent être réutilisés entre modèles’ est techniquement inexacte sans fine-tuning spécifique, ce qui est omis ici, et cela pourrait induire en erreur des développeurs non avertis. Enfin, la référence à Gartner est trompeuse : l’étude n’a pas été publiée, et le chiffre de 85 % est une extrapolation non fondée. Je recommande vivement une relecture critique par un expert en NLP avant publication.

Elodie Trinh

Je viens d’appliquer ça à mon projet de poésie générée, et j’ai fait un test A/B : version compressée à 4x = joli, fluide, presque humain. Version originale = un peu lourd, comme un cours de littérature à 8h du matin 😅 La compression, c’est comme un bon café : pas trop fort, pas trop faible. Juste ce qu’il faut. Et oui, je l’ai mis en prod. Les utilisateurs ont dit ‘vous avez amélioré le bot’… mais ils ne savent pas qu’on a juste coupé les bavardages. 🤫☕

Andre Neves

Intéressant… mais vous avez oublié de mentionner que LLMLingua ne fonctionne pas bien avec les modèles de type MoE, comme Mixtral - ce qui est une lacune majeure pour les utilisateurs avancés. Et puis, ‘quelques lignes de code’ ? C’est ce que disent les blogueurs qui n’ont jamais eu à gérer des pipelines de production avec des logs, des tests, et des SLA. La réalité, c’est qu’il faut un système de validation, un monitoring des hallucinations, et un rollback automatique. Sinon, vous allez envoyer des réponses dangereuses à vos clients. Je l’ai vécu. C’est pas du ‘just do it’ - c’est du ‘do it right’.

Viviane Gervasio

ALERTAAAAA 🚨 C’EST UN PIÈGE DE MICROSOFT ! Ils veulent qu’on compresse tout pour qu’on soit dépendants de leurs modèles ! Et si un jour ils décident de bloquer les invites compressées ? On sera tous à leurs pieds ! Et puis… vous avez vu comment ils ont traité les données des utilisateurs dans leurs tests ? Je vous dis : c’est de la manipulation. C’est pas de la tech, c’est de la surveillance. Ne tombez pas dans le piège ! 🕵️♀️💥

Helene Larkin

La compression fonctionne bien pour les FAQ, mais pas pour les contrats. J’ai vu un avocat perdre un litige parce que la version compressée avait supprimé la clause ‘force majeure’. Le modèle a répondu ‘pas de force majeure’ alors que c’était dans le document original. Il faut tester avec des experts du domaine, pas juste avec des benchmarks. C’est une arme, pas une solution magique.