Les systèmes intelligents qui prennent des décisions sans intervention humaine sont partout : diagnostic médical, contrôle du trafic aérien, gestion des transactions financières. Mais quand une IA se trompe, qui est responsable ? La réponse simple : l’humain. Le codage centré sur l’humain (HCAI) n’est pas une option, c’est une nécessité dans les domaines où une erreur peut coûter des vies. Ce n’est pas seulement ajouter un bouton « annuler » à la fin. C’est réécrire la logique du logiciel pour que l’humain reste un acteur central, pas un spectateur.

Comment le HCAI change la façon de coder

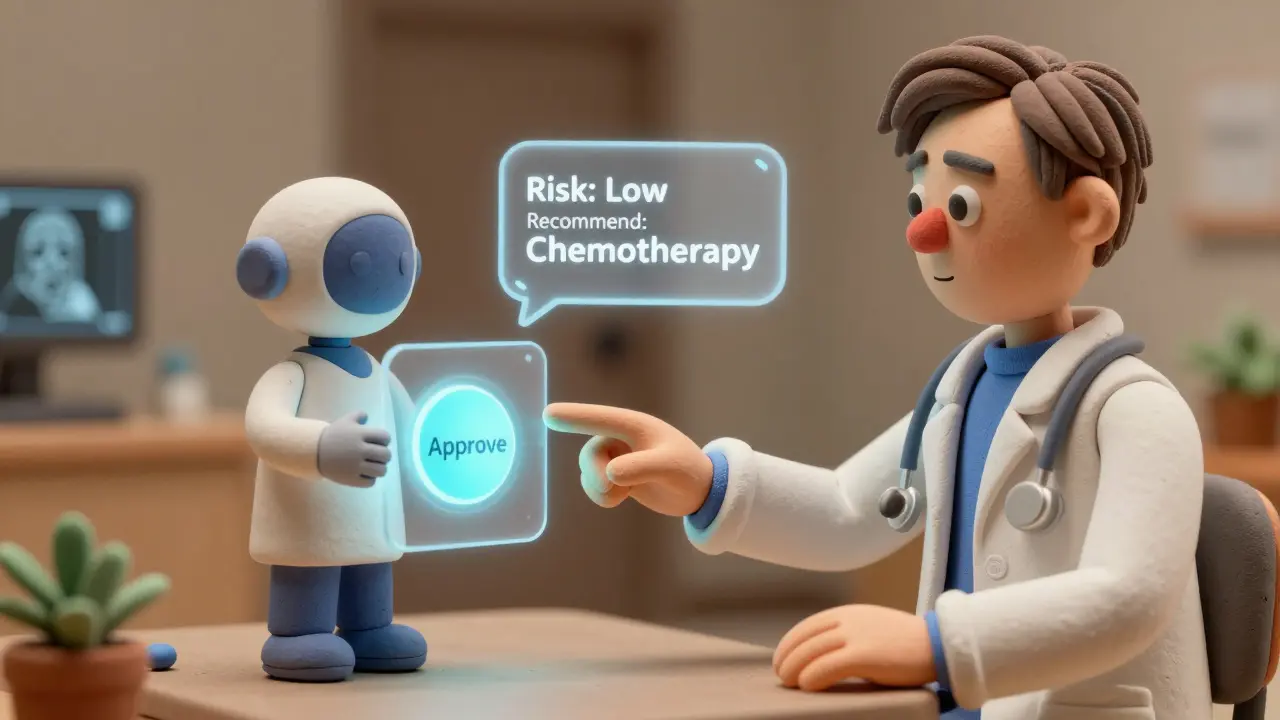

Le HCAI ne fonctionne pas comme une IA classique. Dans un système traditionnel, le code apprend, décide, agit. Dans un système HCAI, le code apprend, propose, attend. Il ne prend jamais la dernière décision. Il attend une validation. Cette différence change tout. Les développeurs doivent maintenant intégrer des points d’intervention explicites dans chaque flux de travail. Par exemple, dans un système d’aide au diagnostic médical, l’IA peut suggérer un traitement, mais elle ne peut pas le prescrire. Un médecin doit cliquer sur « approuver » avant que le système n’envoie la commande. Ce n’est pas une fonctionnalité optionnelle. C’est une exigence technique codée en dur.Les systèmes HCAI incluent des mécanismes comme le human-in-the-loop (HITL), où chaque décision critique passe par un humain. Ils intègrent aussi des couches d’explication : si l’IA recommande une chimiothérapie, elle doit dire pourquoi - en langage clair, pas en chiffres. Des outils comme LIME permettent de générer ces explications automatiquement. Et chaque interaction est enregistrée : qui a validé quoi, quand, et pourquoi. Cela crée une traçabilité totale, indispensable pour les audits de sécurité et les responsabilités légales.

Des chiffres qui parlent

Les données ne mentent pas. Selon une étude McKinsey de 2025 portant sur 157 entreprises, les systèmes HCAI réduisent les erreurs critiques de 37 % et maintiennent un taux de confiance des utilisateurs de 92 %. Dans la santé, un comparatif Gartner montre que les systèmes HCAI sont adoptés 42 % plus souvent par les médecins que les systèmes entièrement automatisés. Pourquoi ? Parce que les professionnels ne se sentent pas remplacés. Ils se sentent soutenus.Les chiffres de l’IEEE sont encore plus frappants : les systèmes HCAI atteignent 99,95 % de disponibilité dans les applications critiques. Ils réduisent les décisions automatisées erronées de 63 % par rapport aux systèmes traditionnels. Mais il y a un prix : un surcoût de 8 à 12 % en ressources informatiques, et une augmentation de 15 à 20 % du temps de développement. Pourtant, dans les secteurs où la sécurité prime, ce coût est justifié. La FDA exige cette approche pour les dispositifs médicaux de classe III. L’UE l’impose par l’article 14 de son règlement IA. Ce n’est plus un choix technique - c’est une obligation légale.

Les limites du HCAI

Mais ce n’est pas une solution universelle. Dans le trading haute fréquence, où les décisions doivent être prises en moins de 1 milliseconde, le HCAI est trop lent. Une étude du Financial Stability Board en 2024 a montré que les systèmes HCAI ajoutent 7,3 millisecondes de latence - ce qui les rend inutilisables dans 83 % des cas. Là-bas, l’automatisation pure est encore la seule option.Un autre problème est l’automation bias : quand les humains commencent à croire que l’IA a toujours raison. Un développeur de Mayo Clinic a raconté sur Reddit comment un système HCAI a évité une catastrophe : l’IA avait mal interprété 12 % des ordonnances, les marquant comme dangereuses. Grâce à l’override humain, les pharmaciens ont pu corriger l’erreur avant qu’elle n’atteigne les patients. Mais dans d’autres cas, les humains ont validé des décisions erronées parce qu’ils pensaient que l’IA savait mieux. C’est le paradoxe du « surveillance humaine » : plus on la rend obligatoire, plus les gens s’y dérobent.

Une étude Brookings en 2025 révèle que 57 % des pannes graves dans les systèmes HCAI ont eu lieu pendant l’intervention humaine, pas pendant l’automatisation. Les opérateurs, surchargés ou fatigués, ont contourné les protocoles. Cela signifie que le HCAI n’est pas une garantie de sécurité - il est une nouvelle forme de risque.

Les 8 règles d’or du codage HCAI

Le professeur Ben Shneiderman, auteur du livre Human-Centered AI, a défini un cadre simple en huit points pour concevoir ces systèmes :- 1. Fonctionnement prévisible : l’IA ne doit jamais agir de manière inattendue.

- 2. Formation continue : les humains doivent être formés régulièrement à interagir avec l’IA.

- 3. Explication claire : chaque décision doit être justifiée en langage naturel.

- 4. Dégradation gracieuse : si l’IA échoue, le système doit revenir à un mode humain sans panne.

- 5. Conscience des ressources : l’IA ne doit pas épuiser les capacités humaines ou techniques.

- 6. Interfaces personnalisables : chaque utilisateur doit pouvoir adapter son interface.

- 7. Autonomie adaptée au domaine : dans un hôpital, l’humain doit décider. Dans un robot de nettoyage, pas nécessairement.

- 8. Contrôle humain absolu : l’humain doit toujours pouvoir arrêter, modifier ou annuler.

Ces règles ne sont pas des suggestions. Elles sont devenues des exigences dans les normes NIST AI RMF 2.1 (janvier 2025) et ISO/IEC 23894:2023. Toute entreprise qui développe un système critique dans l’UE, aux États-Unis ou au Japon doit les respecter.

Comment commencer ?

Vous n’avez pas besoin de tout réécrire. Les outils existent. Microsoft a sorti son Responsible AI Toolkit version 3.2 en juin 2025. Google propose ses directives PAIR. IBM a lancé « Guardrails 4.0 » en avril 2025 - un framework open-source qui insère automatiquement des points de contrôle humain dans le code pendant la compilation. Cela signifie que vous pouvez intégrer le HCAI sans repartir de zéro.Le plus important est de commencer par le bon modèle. Deux approches dominent : human-in-command (l’humain doit approuver chaque action) et human-on-the-loop (l’humain surveille et intervient seulement si nécessaire). Une étude GitHub sur 4 800 projets a montré que le modèle « human-in-command » réduit les bogues critiques de 32 %, mais ralentit le développement de 41 %. Le modèle « human-on-the-loop » est plus rapide, mais plus risqué. Le choix dépend du contexte : une centrale nucléaire ? Choisissez le contrôle strict. Un système de recommandation de musique ? Pas nécessaire.

Le futur : contrôle adaptatif

Le prochain pas n’est pas de faire plus d’humains dans la boucle, mais de faire moins - intelligemment. DARPA finance depuis 2026 un programme appelé « Contextual Autonomy », qui vise à créer des systèmes capables d’ajuster automatiquement le niveau de contrôle humain selon la situation. Par exemple : en temps normal, l’IA gère les alertes de trafic aérien. Mais si une tempête frappe, le système demande immédiatement l’intervention humaine. Ce n’est plus une règle fixe - c’est une intelligence dynamique.La Stanford HAI, en partenariat avec 12 hôpitaux, travaille sur une bibliothèque de code HCAI standardisée pour les systèmes médicaux, avec pour objectif de réduire les erreurs de diagnostic de 50 % d’ici 2027. C’est le futur : des outils reproductibles, vérifiés, partagés. Pas des solutions sur mesure, mais des standards.

Et vous ?

Si vous développez un système qui touche à la santé, la sécurité publique, l’énergie ou la finance, vous n’avez pas le choix. Le HCAI n’est plus une tendance. C’est la norme. Les régulateurs le veulent. Les utilisateurs l’exigent. Les données prouvent qu’il sauve des vies.Ne pensez pas à l’IA comme à un remplaçant. Pensez-y comme à un collaborateur. Un collaborateur qui ne décide jamais seul. Qui vous aide, mais ne vous remplace pas. Le vrai progrès n’est pas dans la puissance de l’IA. C’est dans la sagesse de l’humain qui la contrôle.

Qu’est-ce que le HCAI exactement ?

Le HCAI, ou codage centré sur l’humain, est une approche de développement logiciel qui intègre des mécanismes techniques pour garantir que les humains restent en contrôle des décisions critiques dans les systèmes automatisés. Ce n’est pas une fonctionnalité ajoutée à la fin, mais une architecture fondamentale qui traite le jugement humain comme un composant essentiel du système.

Dans quels secteurs le HCAI est-il obligatoire ?

Le HCAI est obligatoire dans les secteurs à haut risque où la loi exige une supervision humaine : soins de santé (dispositifs médicaux de classe III), transport aérien, gestion de l’énergie, systèmes financiers critiques et infrastructures publiques. L’UE, les États-Unis et le Japon l’imposent via des normes comme le Règlement IA de l’UE, le NIST AI RMF 2.1 et l’ISO/IEC 23894:2023.

Le HCAI ralentit-il les systèmes ?

Oui, il ajoute une latence. Dans les systèmes critiques comme la santé ou l’aviation, cette latence est acceptable. Mais dans le trading haute fréquence, où chaque milliseconde compte, le HCAI est inutilisable. Une étude de 2024 montre une augmentation moyenne de 7,3 millisecondes, ce qui le rend non compétitif dans 83 % des cas de trading ultra-rapide.

Quels sont les outils pour commencer avec le HCAI ?

Vous pouvez utiliser des frameworks open-source comme IBM Guardrails 4.0, le Responsible AI Toolkit de Microsoft (v3.2), ou les directives PAIR de Google. Ces outils offrent des modèles de code prêts à l’emploi pour intégrer des points d’intervention humaine, des explications naturelles et des journaux d’audit dans vos systèmes.

Le HCAI réduit-il vraiment les erreurs ?

Oui, selon une étude McKinsey de 2025, les systèmes HCAI réduisent les erreurs critiques de 37 % et augmentent la confiance des utilisateurs à 92 %. Dans la santé, ils réduisent les erreurs de diagnostic de 28 % par rapport aux systèmes entièrement automatisés. Mais ils peuvent créer un faux sentiment de sécurité : 57 % des pannes graves surviennent pendant les interventions humaines, pas pendant l’automatisation.

Quelle est la différence entre « human-in-the-loop » et « human-in-command » ?

Dans le modèle « human-in-the-loop », l’humain surveille et intervient seulement si l’IA est incertaine. Dans le modèle « human-in-command », chaque décision doit être explicitement approuvée par un humain. Le premier est plus rapide, le second plus sûr. Les projets « human-in-command » ont 32 % moins de bogues critiques, mais 41 % plus lent à développer.

Le HCAI est-il adapté à tous les types d’IA ?

Non. Le HCAI est conçu pour les systèmes critiques où la sécurité, la vie humaine ou la conformité légale sont en jeu. Il n’est pas adapté aux applications où la vitesse prime : trading haute fréquence, recommandations de contenu, chatbots grand public. Dans ces cas, une IA autonome reste plus efficace.